Wstęp

Dwa wieki temu Adam Smith ustanowił zasady architektoniczne, które określają sposób organizacji i funkcjonowania przedsiębiorstw. My przedstawiamy zupełnie nowy sposób myślenia o tym, jak przedsiębiorstwa powinny się organizować i funkcjonować w erze cyfrowej. Prezentujemy architekturę korporacyjną na przyszłość: architekturę, która rozpoznaje siłę powstającego środowiska technologicznego, umożliwia przedsiębiorstwom szybką reakcję do potrzeb rynku i innowacji oraz przewiduje takie potrzeby, wykrywając w czasie rzeczywistym ważne zmiany w środowisku wewnętrznym i zewnętrznym. Przedsiębiorstwa nieustannie starają się być wydajne i konkurencyjne na różne sposoby. Pod wpływem TQM i radykalnych zmian w inżynierii lat 80. i 90. XX wieku wiele przedsiębiorstw próbowało przyjąć orientację procesową jako klucz do wydajności i zróżnicowania konkurencyjnego. Jednak większość osiągnęła jedynie ograniczony sukces w zakresie wydajności procesu. Może to być w dużej mierze spowodowane tym, że w dzisiejszym

dynamicznym środowisku biznesowym statyczny i niereagujący charakter większości paradygmatów technologicznych hamuje znaczący postęp. W ostatnich latach zalew informacji cyfrowych, zwany Big Data, spotęgował to wyzwanie i otworzył przed firmami jeszcze jeden front, w którym można uwzględnić ich strategie. Większość przedsiębiorstw jest poważnie ograniczona z powodu niemożności zmiany swoich procesów w odpowiedzi na potrzeby rynku. Pomimo całej dbałości o zarządzanie procesami biznesowymi i orientację na procesy, firmy nadal borykają się z problemami czasu i elastyczności technologii. Technologia zamiast umożliwiania takich zmian stała się poważnym inhibitorem. Zmiana procesów biznesowych wbudowanych w aplikacje jest często długim, żmudnym procesem pełnym przekroczeń kosztów, przekroczonych terminów i awarii. Szybkie tempo przestarzałej technologii nadal wymaga specjalistycznego szkolenia i umiejętności oraz jeszcze bardziej zaostrzyło ten problem. Aby nadążyć za wymaganiami biznesowymi, firmy skłaniały

się ku pakietom aplikacji przynajmniej do tego, co postrzegali jako funkcje inne niż podstawowe, takie jak planowanie zasobów i rachunkowość finansowa. W przypadku większości przedsiębiorstw utrzymywanie niestandardowej aplikacji technologicznej jest zbyt drogie i trudne środowisko. Początkowo powszechnie uważano, że nowy światowy porządek biznesowy oznacza standaryzację procesów biznesowych, nawet poza funkcjami noncore. Argumentowano, że firmy będą dążyć do ujednolicenia procesów biznesowych z kilku powodów - w celu ułatwienia komunikacji, umożliwienia sprawnego przekazywania połączeń między granicami procesów oraz umożliwienia analiz porównawczych w podobnych procesach. Założono, że zrewolucjonizuje to, w jaki sposób firmy. Ale takie myślenie spowodowało, że przedsiębiorstwa zostały zmuszone do działania w granicach dominujących paradygmatów technologicznych. Zjawisko internetowe pojawiło się jeszcze na przełomie lat 80. i 90. Od połowy lat 90. Internet stał się wszechobecny w życiu osobistym

przedsiębiorstw i ludzi; tempo przepływu nowych informacji było i jest oszałamiające. Szybko rozwijający się Internet przedmiotów obiecuje nadać zupełnie nowy wymiar informacjom w niezwykłej skali. Jeśli dodamy wirusowe rozprzestrzenianie się mediów społecznościowych do nadmiaru informacji, korporacje staną przed ogromnym wyzwaniem i szansą inteligentnego wykorzystania bogactwa wiedzy i wglądu zawartych w takich informacjach. Jednak w ciągu ostatniej dekady przepaść między "technologią mów" a "biznesem mówienia" znacznie się zmniejszyła. Możliwość tworzenia i utrzymywania aplikacji technologicznych jest znacznie łatwiejsza. Era wysoce elastycznych, zorientowanych na proces ram oprogramowania, które umożliwiają korporacji konfigurowanie procesów biznesowych, jest teraz dostępna dla przedsiębiorstw. Jednocześnie pojawiła się zupełnie nowa klasa technologii, aby pomóc przedsiębiorstwom poradzić sobie z gwałtownym wzrostem ilości danych, a rozwój przetwarzania kognitywnego zapewnia szereg możliwości,

które umożliwią maszynom znacznie więcej niż przechowywanie i ułatwianie danych. Przedsięwzięcie jutra ma szansę być inteligentnym i wydajnym. Wymaga to ciągłego monitorowania i analizowania wewnętrznych i zewnętrznych zagrożeń i szans oraz dostosowywania procesów operacyjnych w celu przeciwdziałania takim zagrożeniom lub wykorzystywania szans. W ten sposób nie wystarczy przeanalizować ogromną ilość nieuporządkowanych informacji, które stały się dostępne. Inteligentne przedsiębiorstwo będzie musiało bezproblemowo zintegrować takie procesy analityczne z normalnymi procesami operacyjnymi. Te dwa światy nie są odrębne i dychotomiczne; raczej są część tego samego kontinuum. Bez zintegrowania tych dwóch zestawów procesów przedsiębiorstwa nie osiągną pożądanych rezultatów. Pamiętaj, że przedsiębiorstwa są dalekie od rozwiązania problemu szybkiego dostosowania procesów operacyjnych do dynamicznego środowiska biznesowego. Większość firm wciąż stara się zmusić swoje niezliczone systemy do komunikowania się ze

sobą, problemy z jakością danych wciąż ich dręczą, a lista jest długa. Te zmiany zapowiadają ogromną zmianę w sposobie, w jaki przedsiębiorstwa same się projektują i działają. Historyczne ograniczenia nieodpowiadających paradygmatów technologii będą teraz historią. Dzięki możliwości konfiguracji technologii aby sprostać potrzebom procesów biznesowych, przedsiębiorstwa będą mogły odejść od ciasno spakowanych aplikacji bez kosztów związanych z utrzymaniem niestandardowego oprogramowania. W połączeniu z możliwością potencjalnego zrozumienia nieustrukturyzowanych danych oprócz danych ustrukturyzowanych, przedsiębiorstwa mają możliwość myślenia zupełnie inaczej. Innym faktem jest to, że dzisiejsza architektura korporacyjna jest w dużej mierze skoncentrowana na ludziach. Ludzie byli w dużej mierze klejem do wykonywania procesów biznesowych w przedsiębiorstwie. W wielu przedsiębiorstwach ludzie pełnią funkcję koordynatorów procesów, a zwłaszcza w branżach opartych na wiedzy, ludzie często wykonują swoje

zadania ręcznie. Nadszedł czas, aby technologia stała się organiatorem procesów w przedsiębiorstwie, kontrolowała wykonywanie procesów biznesowych, umożliwiając coraz bardziej automatyczne wykonywanie powtarzalnych zadań. Ludzie będą mieli okazję skupić się na projektowaniu, a nie na powtórnym wykonaniu. Elastyczne ramy oprogramowania i umiejętność zrozumienia znaczenia nieustrukturyzowanych dokumentów zapewnią przedsiębiorstwom ogromną moc w projektowaniu całkowicie nowej architektury prowadzenia działalności gospodarczej. To jest nasza centralna idea. Mamy trzy części. Część I określa bardziej szczegółowo wyzwania, przed którymi stoją przedsiębiorstwa - wyzwania epoki cyfrowej, konieczność dostosowania się do coraz bardziej dynamicznego środowiska biznesowego, brak elastyczności systemów i niemożność zmiany procesów biznesowych w razie potrzeby, ograniczenia związane z pracą w ciasnych warunkach granice spakowanych aplikacji, wady dostosowywania spakowanych aplikacji, unieważniając w ten sposób ich

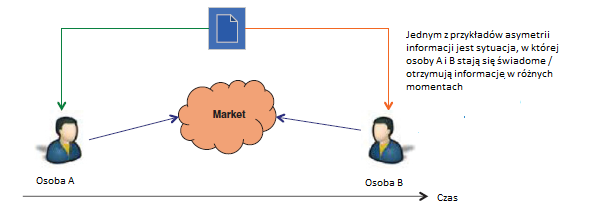

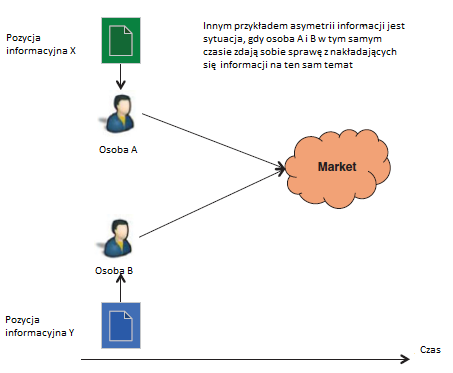

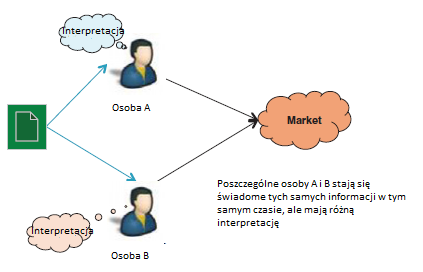

główne zalety, a także gwałtowny wzrost ilości informacji oraz powstałe przeciążenie i asymetria. Część II przedstawia architekturę inteligentnego przedsiębiorstwa. Jak przedsiębiorstwa powinny się projektować w erze cyfrowej? Czy technologia biznesowa jest wystarczająco dojrzała, aby umożliwić firmom dowolną konfigurację i ponowną konfigurację procesów biznesowych? Czy jesteśmy w punkcie, w którym firmy mogą digitalizować procesy biznesowe bez kosztów związanych z kosztownym tworzeniem i utrzymywaniem niestandardowego oprogramowania? W jaki sposób przedsiębiorstwa mogą systematycznie wykorzystywać dane wywiadowcze na podstawie tych wszystkich danych? Po pierwsze, jedna sekcja dotyczy wydajności i sprawności, koncentrując się na korzyściach i wyzwaniach przedsiębiorstwa zorientowanego na procesy. Wszyscy zdajemy sobie sprawę, że outsourcing oparty na arbitrażu pracowniczym wyraźnie nie stanowi odpowiedzi w perspektywie długoterminowej. Dyskusja poprowadzi Cię przez obecny stan technologii biznesowej i

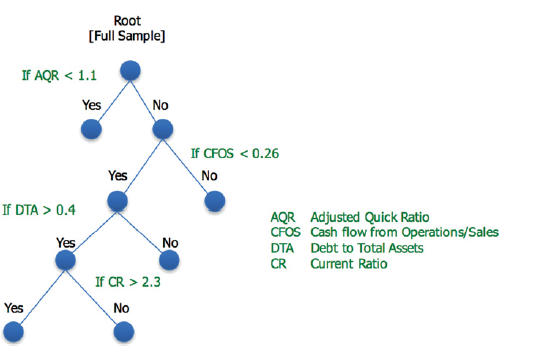

powody, dla których nawet współczesne platformy i metody tworzenia oprogramowania nie zapewniają wydajności i sprawności przedsiębiorstwa muszą być konkurencyjne. Może to zabrzmieć zaskakująco, ale zwinne metody nie zapewnią szybkości i elastyczności, których potrzebują firmy. Żadna platforma oprogramowania oparta na modelu kodu z bogatym zestawem abstrakcyjnych komponentów opartych na modelu nie jest w stanie sprostać wyzwaniu związanemu z wydajnością i sprawnością. Zamiast tego taka platforma może umożliwić w czasie rzeczywistym elastyczne tworzenie oprogramowania i skrócić typowe cykle życia oprogramowania do ułamka tego, czym są inaczej. Dyskusja prowadzi czytelnika przez platformę opartą na modelu bez kodu, która sprawia, że tworzenie oprogramowania w czasie zbliżonym do rzeczywistego staje się rzeczywistością. Część 3 dotyczy wymiaru inteligencji ze szczególnym uwzględnieniem dużych zbiorów danych i sztucznej inteligencji. Celowo wykluczyłem dyskusję na temat wizji komputerowej ze względu na

przestrzeń i czas. Przedstawiono tu taksonomię problemów związanych z AI i ich wyniki w celu wyjaśnienia tego czytelnikowi. Poniżej przedstawiono przegląd popularnych metod rozwiązań AI. Starałem się zrównoważyć nauczanie, które jest zbyt techniczne, a jednocześnie zapewniłem czytelnikowi wystarczającą ilość szczegółów, aby docenić naturę tych metod. Odnosząc te metody z powrotem do taksonomii, mam nadzieję, że czytelnik rozwinie ogólne zrozumienie, w jaki sposób i gdzie AI jest korzystne. Dziewięćdziesiąt procent wzrostu zawartości w Internecie to tekst nieustrukturyzowany. Zwłaszcza, że odnosi się do obsługi języka naturalnego, w rozdziale poruszono ważną kwestię, że większość obecnych metod, platform i narzędzi, w tym IBM Watson i Google, opiera się na statystykach obliczeniowych i nie próbuje zrozumieć tekstu w języku naturalnym. w ogóle. W tej części przedstawiono czytelnikowi ramy inteligencji poznawczej, które próbują opisać język naturalny i zapewnić odpowiednie kontekstowo wyniki. Ponadto

należy dokonać kompromisu między metodami zapewniającymi rozwiązania czarnej skrzynki a metodami zapewniającymi identyfikowalne, odpowiednie kontekstowo rozwiązania. Ramy inteligencji poznawczej przedstawione w tym rozdziale nie są czarną skrzynką, a jej wyniki i rozumowanie są całkowicie identyfikowalne. Część 4 przedstawia architekturę dla przedsiębiorstwa wywiadowczego. Architektura integruje paradygmat architektoniczny oparty na meta-modelu oparty na braku kodu dla wydajności i zwinności z oraz ramy identyfikowalnej inteligencji poznawczej z .Powstała architektura będzie składać się z inteligentnych maszyn uczących się od ludzi i danych. Zasadniczo sugeruję, że w jutrzejszym przedsiębiorstwie aspekty wykonawcze firmy będą w dużej mierze obsługiwane maszynowo, przy czym ludzie będą kierowani przez maszyny, a aspekt projektowy firmy zostanie poinformowany o maszynie w wyniku inteligencji zgromadzonej przez maszyny. Przeglądam także wpływ takiej architektury na obecne miejsce pracy zorientowane na

ludzi. W szczególności ponownie omawiamy debatę o ludziach i maszynach oraz potencjalny wpływ inteligentnego przedsiębiorstwa na miejsca pracy. Część III przedstawia trzy studia przypadków z realnego świata, zawierające pomysły omówione w poprzednich sekcjach. Kolejna sekcja przedstawia architekturę nowej generacji dla firm doradczych w zakresie zarządzania majątkiem. Branża zarządzania majątkiem przeżywa gwałtowne zmiany sejsmiczne w związku z ogromną przemianą milenijną, uznaniem, że historyczny nacisk na dywersyfikację bez wyraźnego uwzględnienia potrzeb inwestorów jest nieoptymalny, a wzrost liczby doradców-robotów rzuca wyzwanie hegemonii dużych domów z drutu. Opisujemy elastyczną inteligentną platformę obejmującą inteligentne maszyny, które mogą umożliwić firmom doradczym ds. Bogactwa i doradcom przejście do wersji E4.0. Przedstawiamy aplikację do systematycznego wykorzystywania danych wywiadowczych w czasie rzeczywistym, aby umożliwić aktywnym podmiotom zarządzającym aktywami generowanie alfa

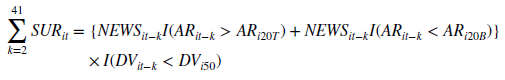

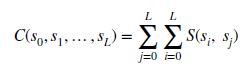

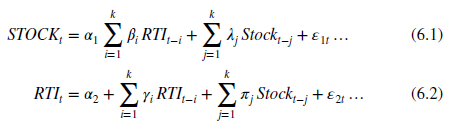

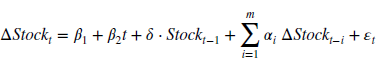

w celu uzyskania lepszych wyników na rynkach finansowych. Konsekwentne znajdowanie alfy to Święty Graal w świecie zarządzania aktywami. Niewiele sektorów w gospodarce jest dotkniętych tak fundamentalnie, jak świat inwestycji, przy ogromnym wzroście dostępności i przepływu informacji. Opisana aplikacja jest elastycznym kompleksowym rozwiązaniem, które obejmuje rozumienie języka naturalnego w celu inteligentnego przetwarzania ogromnych ilości informacji i identyfikowania ewentualnych nieefektywności. Przy takim podejściu aktywne zarządzanie aktywami przejdzie na E4.0. Kolejna część opisuje wykorzystanie inteligencji maszyn w zawodzie audytora. Przemysł ten jest gotowy na poważne zakłócenia. Proces audytu powierniczego i zapewniania jest dziś w dużej mierze ręczny i niewiele się zmienił od lat siedemdziesiątych. Rozwiązanie przedstawione w sekcji stanowi inteligentną architekturę dla firmy audytorskiej. Jak pokazuję w tej książce, dzisiaj istnieje fundamentalnie przekształcająca szansa na

wykorzystanie technologii, jak nigdy dotąd, w projektowaniu cyfrowej transformacji dowolnego przedsiębiorstwa. Okazja wkrótce stanie się koniecznością. Mam nadzieję, że główne idee pomogą liderowi biznesu lub technologii zobaczyć ogromne możliwości zmian. Prawdziwe rozwiązania i opcje, które ilustrują tę tezę, zostały przedstawione w studiach przypadków, pokazują, jak zrealizować te możliwości.

Kryzys nie minął…

Dziś żadna firma nie jest zadowolona z szybkości, z jaką może reagować na szybko zmieniające się warunki rynkowe. Dynamika konkurencji faktycznie się zwielokrotniła, a Internet generuje informacje w zadziwiającym tempie i dodaje kolejny wymiar do i tak już złożonego krajobrazu, z którym mają do czynienia firmy - informacje. Media społecznościowe ostatnio dołączyły do gry, zwiększając zarówno spektrum niekontrolowanego przepływu informacji, jak i możliwość bezpośredniego dotarcia do konsumentów, jak nigdy dotąd. Era radykalnej przebudowy została poprzedzona dwoma innymi ruchami zbiorowymi, mającymi na celu poprawę konkurencyjności, określanymi jako zarządzanie całkowitą jakością (TQM) i Six Sigma. Przeprojektowanie procesów biznesowych (BPR) było kolejną dramatyczną próbą wprowadzenia zmian w firmie. Firma BPR została opisana przez jej zwolenników jako "fundamentalne przemyślenie i przeprojektowanie procesów biznesowych w celu osiągnięcia radykalnej poprawy krytycznych miar wydajności, takich jak koszt, jakość, obsługa i szybkość". BPR zaoferował narzędzia do bardziej efektywnego działania firmy, dzieląc procesy biznesowe i identyfikując bardziej wydajne podejścia. Analizy tych procesów miały być kompleksowe i obejmowały różne dziedziny funkcjonalne. Argumentem było to, że grupy funkcjonalne z czasem staną się chroniące swoją trawę i nie będą informować w obawie, że zmiany mogą w pewnych okolicznościach doprowadzić do wyeliminowania ich kroków w tym procesie. Z pewnością brak widoku dużego zdjęcia procesu biznesowego przedsiębiorstwa często prowadzi do nieoptymalnych decyzji na poziomie funkcji, bez względu na wydajność całego procesu. Jednak strategia BPR zaproponowała analizę, której rezultatem byłoby ponowne złożenie procesu biznesowego w bardziej radykalnie wydajny sposób. Wśród kilku korporacji, które entuzjastycznie przyjęły BPR i procesy Six Sigma, były Motorola i General Electric. Chociaż nie można zaprzeczyć, że Six Sigma uświadomiła ,że jakość procesu i dokładny pomiar, badanie, modelowanie, gromadzenie, a następnie wdrażanie optymalnych procesów trwało zbyt długo. Było to korzystne tylko w operacjach biznesowych, w których istnieje względna stabilność, i że w dzisiejszym szybkim świecie znaczna rzadkość. Chociaż odnotowano kilka znaczących sukcesów, ogólnie rzecz biorąc, reengineering nie znalazł takiego sukcesu, jaki sugerowałaby niekontrolowana popularność książki z 1994 roku. Hallmark podobno całkowicie przeprojektował proces nowego produktu, a Kodak przeprojektował czarno-biały film, aby skrócić o połowę czas reakcji firmy na nowe zamówienia. Krytycznym niepowodzeniem ruchów BPR i TQM w tym czasie był brak wyrafinowanych paradygmatów technologii. Bez paradygmatów technologicznych zgodnych z myślami stojącymi za BPR lub TQM, nie było realnej szansy na powszechny sukces. Chociaż zwolennicy BPR, w tym Champy i Hammer, uznali technologię za czynnik umożliwiający, nie uznali technologii za kluczowy czynnik umożliwiający przeprojektowanie. Ich pogląd na nowy świat pracy koncentrował się na reorganizacji procesów biznesowych z dala od mentalności silosu - jednej osoby wykonującej proces biznesowy od końca do końca zamiast tworzenia zespołu różnych osób skupionych na różnych aspektach tego procesu. Najprawdopodobniej systemowi przeciwnicy BPR wyrzucili wizjonerskie pomysły lub sprowadzili je do zwykłych gier. Spośród wielu innych przeszkód najbardziej rozpowszechnionym inhibitorem był i nadal jest fragmentaryczny, nieelastyczny, kosztowny, niereagujący krajobraz technologii biznesowej, który leży u podstaw wszystkich kluczowych procesów biznesowych, na których działają duże organizacje. W rzeczywistości najlepsi liderzy biznesu i genialni technolodzy muszą z powodzeniem obejść to obciążenie i realizować cele transformacji biznesowej, pomimo ograniczenia technologii, która dopiero niedawno była uważana za zmianę gry. Poniższe studia przypadków oparte są na prawdziwych doświadczeniach. Pokazują, w jaki sposób to wyzwanie poprawiło uruchomienie nowych firm, generowanie przychodów z istniejących firm, zadowolenie klientów i wydajność operacyjną.

Studium przypadku 1: Wdrożenie klienta do usług opieki zdrowotnej

Jeden z największych zewnętrznych administratorów świadczeń opieki zdrowotnej usiłował skalować się, aby zaradzić zmienności systemów klienckich i skutecznie je wdrożyć

• Czas wdrożenia u klienta ,jednego z największych zewnętrznych administratorów ,list płac i świadczeń był dłuższy niż 90 dni.

• Wdrożenie u nowych klientów nie było możliwe dla około trzech kilka miesięcy w roku, podczas gdy dotychczasowi klienci musieli przechodzić coroczne odnowienia.

• Proces ten był wielokrotnie badany przez każdego nowego lidera biznesu, przeprojektowany, częściowo offshorowany przez lata, wprowadzono nowe systemy informatyczne, ale 90-dniowa bariera pozostała nie do pokonania.

• Wdrożenie u każdego klienta było projektem rozwoju oprogramowania; to samo dotyczyło każdej zmiany w istniejących klientach.

• Wynikająca z tego roczna utrata przychodów w wysokości 25% od nowych klientów i niedopuszczalne wrażenia dla obecnych klientów były stałym źródłem znacznej frustracji w branży.

• Firma rutynowo traci klientów.

Najbardziej opłacalna alternatywa. Kontynuuj ukierunkowywanie usprawnień procesów za pomocą projektów Six Sigma i identyfikuj ulepszenia wydajności. Zaakceptuj 25% wskaźnik rezygnacji z dochodów.

Studium przypadku 2: Wprowadzenie nowego produktu globalnej firmy usług finansowych dla jej klientów

Wprowadzenie nowego produktu było kluczowym elementem jego przyszłej strategii wzrostu i było wrażliwe na czas.

• Firma zainwestowała znaczne środki w działania związane z generowaniem popytu, co doprowadziło do uruchomienia.

• Była to transakcja związana z zaciąganiem pożyczek, wymagająca całkowicie zautomatyzowanej platformy klasy korporacyjnej.

• Sześć miesięcy przed uruchomieniem firma utknęła w martwym punkcie jeszcze przed uruchomieniem. Podstawowa struktura technologii procesowej trwała zbyt długo, aby przygotować produkcję.

• Sygnały przed wprowadzeniem na rynek wskazywały na znaczące dostosowania specyfikacji produktu. Aplikacja, na którą liczyła organizacja, została już dostosowana poza punkt krytyczny i przypominała starszą aplikację przed pierwszym dniem produkcji.

Droga do przodu. Zamknij projekt lub zapewnij dodatkowe fundusze na rozpoczęcie działalności, poinformuj rynek o 18-miesięcznym opóźnieniu, opracuj zestaw jasnych wymagań (które pozostaną stabilne w tym 18-miesięcznym okresie) i zaangażuj nowego partnera technologicznego.

Studium przypadku 3: Największa na świecie firma zarządzająca majątkiem, która chce przekształcić swoje usługi dotyczące klientów i doradców finansowych poprzez modernizację raportowania wyników końcowych

Firma musiała poprawić jakość obsługi klienta, aby utrzymać swoich cenionych klientów.

• Narzędzia do raportowania i analizowania wydajności, uzupełnione wewnętrznie opracowanymi rozwiązaniami punktowymi, były niezawodne i solidny, ale nieelastyczny i przestarzały.

• Dwóch zewnętrznych dostawców, którzy otrzymywali wyciągi z portfela od wielu depozytariuszy, ręcznie wprowadzało dane z wyciągów papierowych, często o długości ponad 500 stron.

• Liczba pracowników outsourcingowych rosła szybko, ponieważ firma oferowała swoim klientom szersze usługi raportowania wielostronnego.

• Raporty od wielu powierników były generowane raz na kwartał i były dostępne 45 dni po zakończeniu kwartału, przy czym transakcje dokonane podczas kwartału były zgłaszane gdziekolwiek między 45 a 135 dniem opóźnienia, co czyni je bezużytecznymi.

• Narażenie regulacyjne z minimalnie zarządzanych procesów zlecanych na zewnątrz i utrata krytycznej dla misji nieudokumentowanej wiedzy plemiennej z nieplanowanym zniszczeniem rosła.

Droga do przodu . Utrzymaj koszty operacyjne na płasko, przenosząc zasoby do lokalizacji o niskich kosztach, skróć czas cyklu poprzez obsadzenie personelu, zarządzaj jakością procesów i ryzykiem regulacyjnym poprzez wdrażanie procesów zarządzania dotykiem. Było to ustawienie nieskalowalne. Koszt operacji lub transakcje rosły, ponieważ wzrost liczby błędów przewyższał wszelkie korzyści skali. Lub zaoferuj raportowanie wielostronne mniejszej liczbie klientów, co zniweczyłoby znaczącą przewagę konkurencyjną firmy.

Studium przypadku 4: Zmieniające się na rynku pozyskiwanie przez globalną korporację

Zgodnie z normą wartość transakcji zakładała bezproblemową i udaną integrację przejmowanej firmy oraz uzyskanie wszystkich wynikających z tego synergii.

• Firma przejmująca posiadała 800 głównych aplikacji informatycznych i niezliczone rozwiązania punktowe rozmieszczone w kilku warstwach sedymentacyjnych przez ponad czterdzieści lat lub dłużej.

• W tym czasie każdy kolejny CIO odziedziczył coraz bardziej złożone środowisko z misją standaryzacji, uproszczenia i ustanowienia IT jako strategicznego zasobu dla firmy, ale ostatecznie wiążąc ekosystem aplikacji w coraz ściślejszych węzłach, z powodu sił niezależnych od nich. Gotowe rozwiązania stały się odporne na uaktualnienia.

• Przejęta firma była znacznie mniejsza i posiadała 150 dużych aplikacji. Plan migracji został zaksięgowany przez zbieżne księgi rachunkowe w dniu 1 oraz zintegrowany proces od zamówienia do zapłaty do dnia 365.

Droga do przodu . Plany integracji opracowane przez zespół fuzji i przejęć przy ograniczonym wkładzie technologicznym muszą zostać ponownie zaplanowane od podstaw. Analiza kursowa przeprowadzona przez doświadczony zespół technologiczny firmy przejmującej wykazała, że rozmieszczenie 150 głównych aplikacji w przejmowanej firmie (niezależnie od tego, czy są one zachowane w stanie niezmienionym, zachowane, ale zmodyfikowane, migrowane lub zamknięte) zajęłoby co najmniej pięć lat, gdyby były utrzymane, silny i kaskadowy sponsoring (kadra, finansowanie) w tym okresie, nawet gdy pojawiły się inne priorytety i zmieniło się przywództwo. Żadna z firm nigdy nie doświadczyła niczego zbliżonego do tego. Gdy technologia była ukierunkowana na znaczące cele synergii po przejęciu w pierwszym roku, nawet najbardziej entuzjastyczni członkowie zespołu byli sceptyczni.

Domyślna ścieżka naprzód pokazana dla każdej firmy była prawdopodobnie najlepszym wyborem w danych okolicznościach. Poza tymi przykładowymi przykładami większość inicjatyw związanych z transformacją biznesu jest chroniona, hamowana przez starszą infrastrukturę aplikacji technologicznych, pomimo posiadania najnowszego zarządzania procesami biznesowymi [BPM] oraz innych platform i narzędzi.

Wyzwania związane z obecnymi paradygmatami technologii: chroniczne problemy z czasem wprowadzenia na rynek i elastycznością

Cztery przykłady z życia w poprzedniej sekcji obszernie ilustrują chroniczne wyzwania związane z czasem wprowadzenia na rynek i elastycznością technologii biznesowej. Duże przedsiębiorstwa obfitują w kadrę kierowniczą, sfrustrowaną niezdolnością technologii do sprostania ich wymaganiom. Aplikacje opracowane 20 i 30 lat temu wciąż napędzają znaczną część naszego świata biznesu, nawet jeśli większość otaczających ich rzeczy została wymieniona, odnowiona i opracowana na nowo, w tym sprzęt, na którym działają. Niestety niewiele dużych korporacji ma luksus cofania przeszłości i rozpoczynania od czystej listy technologii. Plany dla nowych firm i plany ambitnej transformacji muszą opierać się na istniejącej, wcześniejszej infrastrukturze aplikacji, która jest wstępnie obciążona następującymi wyzwaniami:

• Nieaktualne starsze aplikacje oparte na przestarzałej technologii obsługującej krytyczne procesy biznesowe, w których koderzy / programiści nie są już dostępni.

• Wiele standardów danych i technologii. Wyjątkowo duży spis narzędzi i aplikacji oraz wynikowa nieoptymalna baza dostawców.

• Gotowe, spakowane rozwiązania, które zostały spersonalizowane poza ich przeznaczeniem i są teraz nowymi aplikacjami starszymi, odpornymi na aktualizację i kilkoma wersjami.

• Wewnętrzne rozwiązania punktowe, które zostały opracowane z wielką intencją, po prostu dodały jeszcze jednego punktu awarii w już wrażliwym środowisku.

• Odpady IT z poprzednich zakupów, które nigdy nie zostały w pełni zintegrowane.

• Firma, która wymaga coraz szybszego reagowania, a IT jest pozbawiona praw.

• Koszty IT są nieproporcjonalnie wysokie.

Nasz krajobraz technologii biznesowych nadal wygląda jak czarno-biały film. Jesteśmy dalecy od posiadania responsywnych aplikacji biznesowych. Nieodpowiadające aplikacje nie mogą obsługiwać środowiska o wysokiej entropii. Dlaczego tak jest? Wyzwanie polega na niezdolności obecnych paradygmatów technologii do spełnienia wymagań dotyczących szybkiego wdrożenia technologii w celu operacjonalizacji działań biznesowych lub strategii. Więc jakie są największe przeszkody, które należy rozwiązać, aby umożliwić znacznie bardziej responsywną architekturę biznesową. Technologia biznesowa musi stawić czoła czterem wyzwaniom, aby umożliwić efektywną architekturę korporacyjną - niezawodność, elastyczność, czas wprowadzenia na rynek i wiedzę. W ciągu ostatnich trzech lub czterech dekad niezawodność została w dużej mierze rozwiązana. Dzisiaj, jeśli szczegółowe specyfikacje zostaną dostarczone wykwalifikowanemu zespołowi technologicznemu, zespół dostarczy niezawodne aplikacje. Istnieje wielu wykwalifikowanych programistów i architektów, którzy mogą dostarczyć stały zestaw specyfikacji. Wraz z pojawieniem się takich standardów, jak Model zdolności do określania zdolności (CMM) i dostępność solidnych baz danych, stosy oprogramowania typu open source stały się kluczowymi czynnikami umożliwiającymi osiągnięcie niezawodności. Jednak elastyczność w zakresie zaspokajania zmieniających się potrzeb biznesowych i czasu wprowadzania na rynek pozostaje znaczącym wyzwaniem. Żadna specyfikacja biznesowa nigdy nie jest kompletna. Żaden ekspert, bez względu na to, jak dobry jest, nie może wyrazić swojej wiedzy specjalistycznej na kilku posiedzeniach. Wiedzę ekspercką można podzielić na wiedzę łatwą do odzyskania i trudną do zdobycia, która pojawia się we właściwym kontekście. Elastyczność w zakresie tego, czego nie znasz, jest znaczącym wyzwaniem w obecnych paradygmatach technologicznych. Większość aplikacji korporacyjnych zajmuje od 12 do 24 miesięcy od rozpoczęcia do pierwszego wdrożenia i często w ograniczonym zakresie. Tak długi cykl często powoduje, że nowa funkcjonalność staje się przestarzała, nawet zanim nowa aplikacja jest gotowa. Czas na wprowadzenie na rynek to ogromne wyzwanie, ponieważ szybkość wdrożenia jest odwrotnie proporcjonalna do elastyczności. Jeśli chcesz znacznej elastyczności, zajmuje to więcej czasu, niż myślisz. Wreszcie wiedza jest stosunkowo nowym wymiarem. Odnosi się do zdolności do proaktywnej analizy ogromnej ilości ustrukturyzowanych i nieustrukturyzowanych danych, którymi dysponujemy, oraz zapewnia wgląd w proaktywne działania. Dlaczego zbudowanie i wdrożenie solidnej aplikacji klasy korporacyjnej zajmuje od 12 do 24 miesięcy? Główna przyczyna leży w metodach, których używamy do tworzenia aplikacji. Każdy stos technologii aplikacji ma trzy segmenty - technologię tworzenia aplikacji (AD), metodologię i infrastrukturę. Infrastruktura poczyniła ogromne postępy i doprowadziła do powstania dwóch pozostałych wymiarów. Pojawienie się "chmury" i możliwość zapewnienia infrastruktury na żądanie w mniejszym lub większym stopniu wyeliminowało infrastrukturę jako wąskie gardło. Podczas gdy dzisiejsze technologie tworzenia aplikacji są znacząco ulepszene w porównaniu z technologiami nawet 5-10 lat temu, miały niewielki wpływ na ogólny czas, jaki upłynął dla aplikacji. Pojawiło się wiele platform technologicznych, takich jak Java, J2EE, Spring / Hibernate, .Net., Java Script i wiele narzędzi typu open source. Dzięki temu programowanie jest łatwiejsze i często szybsze. Nie miały one jednak wielkiego wpływu na upływający cykl ze względu na podstawowy charakter stosowanej metodologii. W konwencjonalnym cyklu rozwoju oprogramowania programowanie jest w rzeczywistości etapem tłumaczenia bez wartości dodanej w procesie tworzenia oprogramowania

Pojawienie się aplikacji w pakiecie

Nastąpiła także znacząca zmiana w środowisku AD od lat 90. XX w., Głównie komercyjne oprogramowanie pakowane zyskuje na popularności, takie jak aplikacje ERP, takie jak SAP i Oracle. Tak powszechne stosowanie aplikacji w pakiecie było w dużej mierze spowodowane długością czasu potrzebną do zbudowania aplikacji wewnętrznych i szybkimi zmianami w krajobrazie technologicznym, z którymi organizacje wewnętrzne nie były w stanie dotrzymać kroku. Istnieją jednak także ogromne luki między takimi aplikacjami a sposobem prowadzenia działalności przez przedsiębiorstwa. Większość luk dotyczyła braku orientacji na procesy biznesowe w tych aplikacjach. Dlatego oprogramowanie nie zapewnia elastyczności, z której można korzystać po wyjęciu z pudełka i wymagało znacznych i kosztownych dostosowań. Co więcej, dostosowania wymagają obszernego programowania i często zajmują zbyt dużo czasu. Oprogramowanie do zarządzania procesami biznesowymi (BPM) pojawiło się dopiero w ostatnim dziesięcioleciu, aby wypełnić lukę między aplikacjami w pakiecie a potrzebami przedsiębiorstwa w zakresie procesów biznesowych. Początkowo pakiety BPM zapewniały obsługę wyjątków i funkcjonalność przepływu pracy. Nawet dzisiaj oferują one bardzo szczegółowe wsparcie dla procesów biznesowych w przedsiębiorstwach. Ponieważ większość z tych pakietów nie została zaprojektowana do obsługi procesu od podstaw i od końca do końca, upłynie trochę czasu, zanim osiągną one drobnoziarnistą elastyczność w rozwiązaniu problemu dynamicznego charakteru potrzeb biznesowych. Chociaż istnieje duża liczba dostawców oprogramowania BPM, większość z nich zasadniczo nie zajęła się elastycznością i czasem wprowadzania problemów na rynek. Oprogramowanie BPM nie jest tanie, szybkie ani elastyczne, chyba że pasuje do gotowego rozwiązania oferowanego przez dostawcę oprogramowania BPM i rzadko jest tak ścisłe. Niezmiennie, biorąc pod uwagę gruboziarniste wsparcie dla procesów biznesowych przez wszystkie obecne BPMS, wdrożenie zazwyczaj wymaga dużej ilości konwencjonalnego programowania. Oczywiście wynikiem jest długi cykl wdrażania i brak elastyczności. Przejście na aplikacje w pakiecie wiązało się jak dotąd z kosztem. Odebrało to zdolności przedsiębiorstwa do konkurowania. Jest to szczególnie dotkliwe w usługach finansowych, w których proces biznesowy jest produktem. Wyjaśnia to, dlaczego firmy świadczące usługi finansowe nadal budują we własnym zakresie stosunkowo wysoki poziom aplikacji. Pakiety aplikacji do podstawowej rachunkowości i innych funkcji prowadzenia dokumentacji, które są statyczne bez możliwości tworzenia przewagi konkurencyjnej, są całkiem zrozumiałe. Jednak aplikacje w pakiecie stają się aplikacjami starszymi od momentu ich wdrożenia, chyba że oferują znaczną elastyczność, którą można dostosować do potrzeb przedsiębiorstwa. Dlatego nawet dziś aplikacje stają się bardziej elastyczne, w większości zapewniają klientom ograniczoną elastyczność. Przejście na aplikacje pakietowe może być przyznaniem się do porażki przez biznesmenów i technologów ze względu na ich niezdolność do dostarczania technologii zgodnej z potrzebami biznesowymi. Chociaż rozsądne może być kupowanie rozwiązań pakietowych zamiast zatrudniania eksperta do tworzenia oprogramowania od zera, ostatecznym celem powinna być możliwość dostosowania lub skonfigurowania takiego rozwiązania w celu dostosowania go do zmian potrzeb biznesowych

Nowy front: informacja, Big Data nie jest nowy, nowością jest informacja nieustrukturyzowana

Ogromny niewykorzystany potencjał strategiczny i operacyjny ukryty w zasobach informacji i wiedzy w cyberprzestrzeni to najnowszy nowy wymiar, który wpłynie i ukształtuje architekturę przedsiębiorstwa w przyszłości. Oferuje kuszące możliwości inteligentnej architektury korporacyjnej w czasie rzeczywistym. Technologia uwalniająca potencjał dużych zbiorów danych i sprawiająca, że jest praktyczna i ma zastosowanie w tworzeniu nowej wartości dla starych (i nowych) firm, jest wciąż w powijakach i opóźnia szum wokół dużych zbiorów danych z dużej odległości. Analityka predykcyjna (statystyczna analiza przeszłości w celu prognozowania przyszłości) istnieje od dziesięcioleci i stanie się jeszcze potężniejsza, ponieważ będzie wskazywać na coraz większe, ale ustrukturyzowane dane. Analizy mediów społecznościowych, nowsze zjawisko, pobudziły wyobraźnię i inwestycje organizacji, które chcą poznać opinię publiczną na temat swoich produktów, marki lub firmy w oparciu o rozmowy na platformach społecznościowych, a następnie za pomocą tych samych mediów do kierowania opinii lub podejmij inne działania. Istnieje również szybko rosnąca populacja naukowców zajmujących się danymi, którzy mają za zadanie oswajanie dużych zbiorów danych poprzez stosowanie matematyki, wspierane przez organizację. To, co nadal pozostaje poza zasięgiem analizy predykcyjnej, podstawowego słuchania w mediach społecznościowych i lekko uzbrojonych naukowców zajmujących się danymi, to ogromny i wykładniczo rosnący wszechświat nieustrukturyzowanych danych, zarówno na zewnątrz, jak i wewnątrz murów korporacyjnych. Jak zauważono w badaniu IDC Digital Universe Study sponsorowanym przez EMC Inc., 90% wszystkich danych było nieuporządkowanych, a biorąc pod uwagę ówczesną technologię, głównie niedostępnych dla przetwarzania maszynowego. Branża technologii dużych zbiorów danych rozwija się w szybkim tempie od 40 do 60%, w zależności od źródła, któremu ufasz. Jednak ponad 80% tych wydatków jest przeznaczone na infrastrukturę, pamięć masową i bazy danych. Tylko 20% tej inwestycji jest przeznaczone na aplikacje biznesowe dla dużych zbiorów danych (wikibon, 2012). Z 20% tylko niewielka część koncentruje się na wykorzystaniu największej możliwości dużych zbiorów danych - analizie nieustrukturyzowanych danych. Fakt, że produkujemy informacje w tempie, które od dawna przewyższa możliwości przetwarzania ludzi, doprowadził nas nawet do stosowania słów i zwrotów, takich jak "szum", "paplanina" i "przeciążenie informacją", aby opisać to zjawisko o niskim stosunku sygnału do szumu, tak jakby problem był w jakiś sposób związany z informacją, a nie z naszą zdolnością radzenia sobie z nią. Większość przedsiębiorstw stara się jednocześnie uzyskać dostęp do informacji pochodzących z tak ogromnej ilości nieuporządkowanych danych i wykorzystać je. Podczas gdy pośpiech do dużych zbiorów danych przyciągnął najlepsze umysły i duże pieniądze, pozostawanie na czele i odkrywanie znaczenia w oceanie niepowiązanych fragmentów informacji, pojawiających się nieustannie i dostępnych 24 godziny na dobę przez cały czas rosnących ilości, okazało się być przeważnie przegrana bitwa o pionierów. Czołowi analitycy branżowi sugerują, że hype i obietnica związana z dużymi zbiorami danych przeważnie ustąpiła miejsca mniej ambitnemu wewnętrznemu ukierunkowaniu w dużych korporacjach w dającej się przewidzieć przyszłości. Poszukiwanie wglądu w wewnętrzne dane strukturalne sprawiło, że wykorzystano potencjał świata nieustrukturyzowanych informacji "tam" na kolejny dzień.

Architektura korporacyjna: obecny stan i implikacje

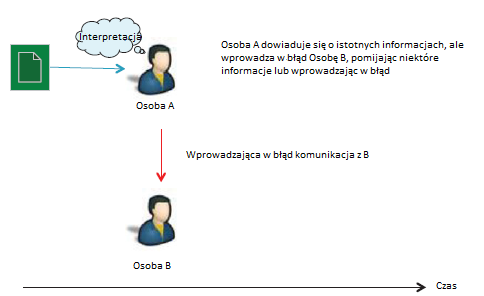

Zasadnicze znaczenie dla kwestii konkurencyjności przedsiębiorstw ma pytanie, w jaki sposób przedsiębiorstwa organizują się i konkurują? Taka architektura korporacyjna ma zasadnicze znaczenie dla problemów przedstawionych powyżej i może ulec głębokiej transformacji w miarę pojawiania się rozwiązań wyżej wymienionych problemów. Post Adam Smith architektura korporacyjna oparta była na zasadzie podziału pracy i koncentrowała się na wyspecjalizowanych funkcjach. Każda funkcja miała stać się wysoce kompetentna i zapobiegać fragmentacji umiejętności w zakresie wytwarzania produktu końcowego na dużą skalę. W epoce nowożytnej ze znacznie płaskim światem i wszechobecnym wpływem technologii było wielu zwolenników procesu biznesowego i architektury centrycznej. Hammer i Champy zdecydowanie wyrazili swoje stanowisko w swojej zasadniczej pracy w 1993 roku. Dużo dyskutowano na temat tego, czy przedsiębiorstwo powinno być zorganizowane według funkcji czy procesu. Wszystkie te struktury sugerują jednak, że architektura jest "prowadzona przez ludzi". Ludzie są w centrum organizacji i realizacji pracy. W związku z tym możemy myśleć o architekturze przedsiębiorstwa jako o projekcie / strategii i wykonaniu. Procesy biznesowe są projektowane przez ludzi posiadających niezbędną wiedzę fachową i odzwierciedlają ich wizję, wiedzę i ogólną misję organizacji. Po zaprojektowaniu i wdrożeniu wszystkich komponentów, wszystkie odpowiednie transakcje biznesowe stanowią wielokrotnie wykonywany proces biznesowy.

Inteligentne przedsiębiorstwo jutra

Postęp technologiczny, gwałtowny wzrost informacji i pojawienie się natychmiastowej komunikacji wirusowej połączyły się, tworząc dynamicznie zmieniające się środowisko dla przedsiębiorstw. Ma to dalekosiężne konsekwencje dla samego projektu architekta. Uważamy, że aby przedsiębiorstwa odniosły sukces w takim środowisku, muszą od nowa przemyśleć każdy aspekt swojej działalności. Rzeczywiście może się zdarzyć, że podstawowe podejście do architektury korporacyjnej "kierowane przez ludzi" powinno się zmienić, aby umożliwić maszynom pełnienie większej roli w architekturze korporacyjnej. Jaką rolę mogą odgrywać maszyny w architekturze? Z pewnością będzie się to różnić w zależności od branży i firmy, ale nie ma wątpliwości, że maszyny będą coraz bardziej przejmować rolę wykonawczą. I w coraz większym stopniu będą pomagać ludziom w aspekcie projektowym dzięki zgromadzonej inteligencji, której ludzie po prostu nie mogą zebrać samodzielnie. Niemniej jednak maszyny będą musiały zostać poinstruowane przez ludzkich

ekspertów w zakresie gromadzenia takiej inteligencji, a takie instrukcje będą musiały być stale monitorowane i dostosowywane. Takie są wyzwania omówione w tej książce. W kolejnych sześciu rozdziałach staramy się nakreślić, jaką formę przyjęłaby optymalna architektura dla inteligentnego przedsiębiorstwa.

Wydajność i zwinność

WPROWADZENIE

Większość przedsiębiorstw stara się być bardziej wydajna i zwinna w reagowaniu na zmieniające się wymagania swoich klientów i zmieniającą się dynamikę otoczenia biznesowego. Jednak w dzisiejszym połączonym świecie prawdziwym kluczem do osiągnięcia wydajności i sprawności jest skuteczne wykorzystanie technologii. Jak omówiono w poprzednim rozdziale, technologia jak dotąd nie zapewniła wydajności i sprawności, której większość firm oczekuje i potrzebuje. W tym rozdziale omawiamy nasze kroki poprzez ewolucję paradygmatu technologii, który może umożliwić elastyczne tworzenie oprogramowania w czasie rzeczywistym. Wierzymy, że zapoczątkuje to erę niespotykanej szybkości i szybkości reakcji.

PRZEDSIĘBIORSTWO ZORIENTOWANE W PROCESIEM

W prasie popularnej toczy się znaczna dyskusja na temat zalet organizacji zorientowanych na procesy. Obecnie większość firm uważa, że aby być konkurencyjnym i wydajnym, musi być zorientowana na proces pod względem struktury organizacyjnej, zamiast organizować z funkcjonalną orientacją. Wiele korporacji jest nadal zorganizowanych w sposób funkcjonalny, hierarchiczny. Są one zorganizowane hierarchicznie w obszarach funkcjonalnych, takich jak sprzedaż, marketing, finanse lub produkcja. Odzwierciedlają wagę przywiązywaną do umiejętności w wewnętrznie ukierunkowanym spojrzeniu na zarządzanie organizacyjne. Ta struktura korporacyjna pojawiła się w rewolucji postindustrialnej, gdy duże korporacje posunęły podział pracy i specjalizację w celu ujednolicenia procesów produkcyjnych i utrzymania konkurencyjnych korzyści skali. Powszechnie wiadomo, że taka struktura organizacyjna zapewnia spójność w wytwarzaniu towarów i rozpowszechnianie standardów w ramach tej funkcji. W organizacjach koncentrujących się na poprawie korzyści skali, implikacje międzyfunkcyjne są rozpatrywane na wyższych szczeblach zarządzania w organizacji. Jednak takie organizacje często tworzą funkcjonalne silosy w swoich strukturach. Takie organizacje, z kilkoma wyjątkami, często zapewniają klientom mniej niż optymalne doświadczenia. Wynika to z faktu, że organizacja nie ma holistycznego nacisku na zapewnienie wyjątkowej obsługi klienta. Często zdarzają się awarie w przekazywaniu podczas wykonywania procesu między obszarami funkcjonalnymi, co powoduje mieszanie w celu ochrony doświadczenia klienta. Podczas gdy organizacje zorientowane na funkcje umożliwiły przedsiębiorstwom skalowanie w erze rewolucji postindustrialnej, pojawienie się Internetu wraz z postępami w dziedzinie komunikacji mobilnej i technologii wyraźnie pokazały słabości organizacji zorientowanej na funkcje. W tym płaskim, dynamicznym świecie zdolność do dostosowywania i wprowadzania innowacji w procesach biznesowych stała się kluczowa dla utrzymania przewagi konkurencyjnej. Kluczową cechą organizacji zorientowanej na procesy są natomiast procesy biznesowe. Hammer i Champy określają proces biznesowy następująco:

…Zbiór działań, które wymagają jednego lub więcej rodzajów danych wejściowych i tworzą wyniki, które są wartościowe dla klienta.

Thomas Davenport (1993) definiuje proces bardziej zwięźle:

Po prostu ustrukturyzowany, mierzony zestaw działań zaprojektowanych w celu uzyskania określonej produkcji dla konkretnego klienta na rynku. Oznacza to duży nacisk na sposób wykonywania pracy w przedsiębiorstwie, w przeciwieństwie do nacisku skoncentrowanego na produkcie na czym. Proces jest zatem specyficznym uporządkowaniem czynności roboczych w czasie i miejscu, z początkiem, końcem i jasno określonymi danymi wejściowymi i wyjściowymi: strukturą działania.

W definicji procesu Davenporta istnieje kluczowe rozróżnienie między "sposobem wykonywania pracy" a "tym, co jest wykonywane". "Proces" jest dokładniej ograniczony do "jak". W obu interpretacjach kładziony jest wyraźny nacisk na ostateczną wartość dla klienta. Rummler i Brache rozszerzają definicję, wprowadzając rozróżnienie między procesami podstawowymi a procesami wsparcia w oparciu o to, czy wartość klienta jest bezpośrednio dostrzegalna w procesie, niezależnie od tego, czy jest ona jednak niezbędna. Nasza definicja procesu biznesowego jest znacznie bardziej całościowa. Definiujemy firmę (lub korporację) jako zbiór procesów o odpowiednich celach wobec interesariuszy (klientów, pracowników, inwestorów, organów nadzoru itp.). Naszym zdaniem proces jest zdefiniowaną sekwencją działań biznesowych z parametrami wejściowymi i wyjściowymi dla każdego zadania oraz z jasno określonymi celami w odniesieniu do interesariusza. Proces ten dotyczy zarówno "jak" zadań do wykonania, jak i "jakie" zadań do wykonania. Uważamy, że "co" w większości przypadków nie da się oddzielić od "jak", ponieważ często "co" określa cele "jak" w procesie. W ten sposób w definicji procesu nie brakuje celu i pomiaru. Nie definiujemy procesu synonimicznie z przepływem pracy, ponieważ znacznie osłabia to definicję procesu poprzez ignorowanie "pracy" w procesie lub głównych zadań biznesowych procesu. Nasza definicja procesu jest bardziej kompleksowa i obejmuje zarówno "pracę", jak i "przepływ pracy" związany z procesem. Każdy proces biznesowy w organizacji zorientowanej na procesy zazwyczaj należy do "właściciela procesu". Zespoły procesowe kierowane przez właściciela procesu będą obejmować członków z różnych grup umiejętności lub grup funkcyjnych i będą mieli pełny widok. Dlatego zespoły procesowe koncentrują się na ostatecznych celach procesu, niezależnie od tego, czy chodzi o dostarczenie doświadczenia klienta, czy, powiedzmy, o gotówkę. Zorientowana na proces struktura organizacyjna eliminuje funkcjonalne silosy i ułatwia konwergencję w kierunku celu procesu. Nie ma tarcia między różnymi grupami funkcjonalnymi, które wykonują swoje oddzielne zadania w tym procesie. Mogą bardziej naturalnie wykorzystywać swoje umiejętności i dalej wprowadzać innowacje. Niezależnie od zalecanych przez nie podejść i metod ukierunkowania na proces, wielu autorów dostrzega znaczące korzyści dla organizacji zorientowanych na proces. Hammer (2007) przekonuje, że organizacje mogą poprawić jakość swoich produktów i usług, czas wprowadzania na rynek, rentowność i inne wymiary, koncentrując się na procesach zorientowanych na klienta. Hirzel (2008) podobnie przytacza skrócenie czasów cyklu dostarczania produktu, odpowiadając na potrzeby klientów w wyniku przyjęcia ukierunkowania na proces. Ligus (1993) podaje bardzo szczegółowe szacunki dotyczące poprawy różnych wskaźników - skrócenia czasu dostawy o 75-80%, zmniejszenia poziomu zapasów nawet o 70%, a nawet zwiększenia udziału w rynku przy ukierunkowaniu na proces. Kohlbacher wymienia wzrost zadowolenia klientów, poprawę jakości produktów i usług, ogólne obniżenie kosztów, poprawę szybkości reagowania na potrzeby klientów, jako główne zalety przyjęcia systemu zorientowanego na proces. Rzeczywiście wydaje się, że istnieje znaczna zgoda co do tego, że orientacja procesowa zapewnia organizacji większą wydajność i sprawność w porównaniu z brakiem orientacji procesowej.

Zorientowanie na proces

W rzeczywistości niewiele organizacji było w stanie osiągnąć prawdziwą orientację na proces głównie ze względu na ograniczenia technologii i znaczną zmianę kultury wymaganą do osiągnięcia takiej orientacji. Nawet te organizacje, które utworzyły i wykorzystują funkcje ukierunkowane na procesy, mają trudności z efektywnym zarządzaniem zmianami kulturowymi wymaganymi do uruchomienia systemów zorientowanych na procesy. Prawdziwa orientacja na proces wykracza daleko poza organizowanie według procesów. Wymaga to zmiany w sposobie myślenia członków organizacji i internalizacji tego, co to znaczy być zorientowanym na proces. Hammer wskazuje, że władza większości firm opiera się na pionowych jednostkach - czasem koncentrujących się na regionach, czasem na produktach, a czasem na funkcjach - i te lenna wciąż zazdrośnie strzegą swojej ziemi, ludzi i zasobów. Powoduje to, że środowisko przyciąga ludzi w różnych kierunkach, podnosi tarcia organizacyjne i obniża wydajność organizacji. Stwierdzamy również, że ostatecznie skrajna frustracja związana z niezdolnością organizacji zorientowanych na funkcje do reagowania na potrzeby rynku prowadzi do dużych projektów transformacyjnych ukierunkowanych na procesy. Frustracje te mogą narastać do tego stopnia, że wewnętrzne nieefektywności prowadzą do hurtowego mandatu do wewnętrznej lub zewnętrznej transformacji. Takie projekty często przekraczają linie funkcjonalne. Często słyszysz o projektach typu "jeden i zrobiony", co oznacza, że wiele zbędnych punktów interakcji, wprowadzania informacji lub dotyku klienta, spowodowanych orientacją funkcjonalną, należy zredukować do jednego zintegrowanego punktu. Pewnego razu pracowałem z dużą firmą zajmującą się produktami informatycznymi, która miała 19 różnych systemów, które gromadziły mniej więcej te same podstawowe dane finansowe firmy. Często występowały błędy i poważne problemy z jakością w tym, co dostarczali swoim klientom. Kwestie narosły do tego stopnia, że kierownictwo wyższego szczebla musiało usankcjonować projekt transformacji zatytułowany "jeden i zrobiony". Projekt miał międzyfunkcyjnego właściciela, który miał wsparcie kierownictwa wyższego szczebla, aby przecinać silosy organizacyjne w celu wdrożenia "jednego i gotowego". Ostatnio natknąłem się na globalną firmę logistyczną, która ma wiele systemów na całym świecie, zorganizowanych według położenia geograficznego, które współdziałają w obsłudze zamówień klientów. Ta firma nie jest w stanie zapewnić spójnej i dokładnej odpowiedzi na zapytania i skargi klientów, w wyniku czego poziom zadowolenia klientów jest niski. Nie ma skoordynowanego procesu reakcji klienta i często ten sam klient działający w dwóch różnych regionach geograficznych otrzymuje różne usługi w zależności od tego, gdzie rejestruje swoją opinię. Odpowiedzi przedstawicieli obsługi klienta różnią się jakością w oparciu o ich wiedzę o produktach i procesach firmy. Firma stwierdziła, że często początkowa klasyfikacja skargi klienta była nieprawidłowa i często klasyfikacja zmieniała się podczas interakcji z klientem. Kontrowersje z klientem spowodowały wiele frustracji po stronie klienta. Ta firma rozpoczęła teraz ogromny projekt transformacji. Projekt ma jednego właściciela z różnych obszarów geograficznych i funkcji oraz ma uprawnienia do tworzenia zdolności do zapewniania klientom spójnych, dokładnych i terminowych odpowiedzi. Oba powyższe przypadki były przypadkami narastania problemów do momentu, w którym organizacja zmuszona jest dokonać radykalnej zmiany, aby nadal funkcjonować. Oczywiście, zanim organizacja uzna potrzebę, wiele jej reputacji uległo pogorszeniu. Istnieje znaczna literatura na temat mierzenia poziomu orientacji procesowej osiągniętej przez firmę i jej poziomu dojrzałości procesowej. Badacze i praktycy zaproponowali szereg modeli dojrzałości procesów biznesowych - model dojrzałości zorientowanej na procesy biznesowe, ramy możliwości BPM, model dojrzałości procesów i przedsiębiorstw oraz model dojrzałości procesów biznesowych grupy zarządzania obiektami należą do często określanych modeli. Tarhan i in. stwierdzili jednak, że po wszechstronnym przeglądzie literatury brakuje dowodów na powiązanie poziomu dojrzałości procesowej organizacji, mierzonej za pomocą jednego z powyższych modeli dojrzałości, do poprawy wyników biznesowych. Chociaż wydaje się, że jest to nieco sprzeczne z cytowanymi wcześniej ustaleniami dotyczącymi korzyści z orientacji na proces, różnica prawdopodobnie leży w stopniu korzyści i definicji modeli dojrzałości procesów biznesowych. W praktyce większość organizacji jest hybrydą podejść zorientowanych na procesy i funkcje. Nawet te organizacje, które dokonały przejścia do zorientowania na proces, są zorientowane na proces do pewnego momentu i stają się hierarchiczne ponad pewien poziom.

Dlaczego musimy wybrać?

Dlaczego organizacje muszą wybierać między orientacją procesową a funkcjonalną? Debata na temat zalet i wad procesu w porównaniu z orientacją funkcjonalną nieodłącznie odzwierciedla ograniczenia technologii i ograniczoną rolę, jaką technologia odegrała w umożliwieniu organizacjom zwiększenia wydajności i sprawności. Uważamy, że brak skutecznych paradygmatów technologii jest głównym powodem, dla którego firmy napotykają takie trudności w ukierunkowaniu procesu od podstaw. Gdyby paradygmaty technologii były elastyczne, wówczas firmom byłoby znacznie łatwiej zorientować się na proces. Możemy nawet pójść o krok dalej. Dlaczego technologia nie może umożliwić organizacjom posiadania dynamicznych struktur, które bezproblemowo zaspokajają potrzeby zarówno funkcjonalne, jak i procesowe? Dzięki postępowi technologicznemu uważamy, że organizacja może być jednocześnie zorientowana na proces i funkcjonalność, bez pociągania w obu kierunkach. Taki scenariusz przedstawiamy w dalszej części

Projekt i wykonanie

Istnieje jeszcze jeden wymiar organizacji przedsiębiorstwa, któremu nie poświęcono wiele uwagi w literaturze - projekt kontra wykonanie. Ważne jest, aby dostrzec różnicę między projektowaniem a wykonaniem w architekturze przedsiębiorstwa. Projektowanie odnosi się do projektowania różnych strategii, modeli biznesowych i procesów biznesowych. Każdy proces biznesowy jest zaprojektowany przez osobę i jest wykonywany przez jedną lub więcej osób w organizacji. Czasami są to ci sami ludzie. Te dwie role są jednak bardzo różne i oddzielne w dojrzałej organizacji. Leymann i Alternhuber [1994] uznają, że procesy biznesowe mają aspekt kompilacji i czasu wykonywania. Po zaprojektowaniu procesów biznesowych są one wielokrotnie wykonywane przez część wykonawczą organizacji. Niezależnie od tego, czy organizacja jest zorientowana na funkcję, czy na proces, niektóre osoby będą koncentrować się na projektowaniu i dużej części organizacji na realizacji. Część wykonawcza dowolnego procesu biznesowego została oczywiście dostosowana do automatyzacji ze względu na nieodłączną powtarzalność procesu montażu. Do niedawna projektowanie było w gestii ludzi. Projektanci określani są również jako "właściciele procesów" i często są ekspertami w tej dziedzinie lub ekspertami w zakresie operacji / procesów. Korzystają z wiedzy innych osób, myśląc o najlepszym sposobie zaprojektowania procesu. Natomiast wykonawcy są odpowiedzialni za wykonanie procesu określonego przez projektantów. Projektowanie wymaga odrębnego zestawu umiejętności, wiedzy i informacji. Wykonanie wymaga zupełnie innego zestawu umiejętności, wiedzy i informacji. Projekt jest oparty na wynikach wykonania.

ROLA OUTSOURCINGU W TWORZENIU EFEKTYWNOŚCI I ZWINNOŚCI

Offshoring jest obecnie uznawany za rewolucję społeczną na równi z rewolucją przemysłową. Przez długi czas produkcja była w dużej mierze wykonywana w rozwiniętym świecie dla rynków rozwiniętych, a usługi były podobnie wytwarzane i konsumowane na każdym oddzielnym rynku. Jednak w latach 80. outsourcing produkcji w lokalizacjach morskich, zwłaszcza w Chinach, stał się dość dobrze ugruntowany. Najczęściej mówionym i widocznym outsourcingiem było przeniesienie procesów produkcyjnych do krajów o bardzo niskich kosztach pracy. Spowodowały one znaczne zakłócenia w całych branżach w Stanach Zjednoczonych, zwłaszcza w produkcji tekstyliów. Te operacje produkcyjne przeniosły się na cały świat, przenosząc się do nowych lokalizacji, gdy zmieniają się różnice w względnych kosztach pracy. Wiele organizacji początkowo zlecało produkcję do Meksyku, a następnie do krajów azjatyckich. Outsourcing usług związanych z technologią pojawił się pod koniec lat 80. XX wieku i nadal znacząco rośnie w latach 90. i późniejszych. Covansys, z siedzibą w Farmington Hills w stanie Michigan, był jednym z pierwszych, którzy specjalizowali się w pomaganiu amerykańskim firmom w przeprowadzce za granicę i utworzeniu indyjskiego zakładu w 1992 r. American Express od 1994 roku przenosi różne funkcje biznesowe do Indii. Moje pierwsze przedsięwzięcie, eCredit, wyjechało za granicę z centrum rozwoju oprogramowania dla niewoli w Bangalore w 1994 roku. GE Capital uruchomił w Indiach firmę GE Capital International Services (GECIS) w Indiach , która od tego czasu została wydzielona jako niezależna firma Genpact. Wszystkie główne firmy świadczące usługi finansowe wykorzystały czynniki kosztów, aby uzasadnić offshoring wielu funkcji, od opracowywania oprogramowania po obsługę klienta. Między 1989 r., Kiedy Kodak zlecił outsourcing technologii informatycznej, a 1995 r., Rynek outsourcingu IT wzrósł do 76 miliardów dolarów. Zarówno outsourcing produkcji, jak i procesów biznesowych był w dużej mierze oparty na kosztach arbitrażu. Koncepcyjnie offshoring i outsourcing są realizacją przyjęcia doktryny wolnego handlu i zakorzenione w zasadach wytwarzania towarów i usług, w których można to zrobić najskuteczniej. Sawhney nazwał tę dźwignię względnych różnic kosztów w poszczególnych krajach "globalnym arbitrażem". Moxon empirycznie zbadał niedrogą siłę roboczą jako podstawową motywację do produkcji offshore dla przemysłu elektronicznego. Znaczenie kosztów produkcji zasugerowano również w badaniach systemu informacyjnego. Najwyraźniej postęp w dziedzinie technologii komunikacyjnych i komputerowych w ostatnich latach sprawił, że ten argument stał się jeszcze bardziej wiarygodny, a możliwości offshoringu coraz bardziej realne, szczególnie w dziedzinie usług. Wraz ze wzrostem "eksportu" wysoko wykwalifikowanych, wysoko płatnych miejsc pracy wzrosło również oczekiwanie na korzyści kosztowe. Chociaż istnieją inne argumenty wspierające na rzecz outsourcingu, takie jak jakość i czas dostawy, nie ma dowodów na dużą skalę potwierdzających te argumenty jako główną przyczynę. Podczas gdy liczba miejsc offshoringowych wzrosła z biegiem lat, a Chiny, Malezja, Filipiny i Republika Południowej Afryki szybko wkraczają w Indie (The Economist, 2003a, b), Indie nadal pozostają najważniejszym miejscem docelowym outsourcingu procesów biznesowych. Wykorzystując dane indyjskiego przemysłu BPO jako przybliżenie dla globalnego przemysłu BPO, od gwałtownego wzrostu o ponad 60% w latach 2003-2004, stopy wzrostu w branżach BPO i ITES w Indiach znacznie spadły do niskich podwójnych cyfr w latach 2014-2015, ponieważ z następujących czynników:

• Inflacja płac: Przewaga kosztowa Indii jako miejsca docelowego offshoringu, jej atutu, spadła o 30-40%. I z każdym rokiem spada.

• Wysokie ścieranie: przy 40-50% ścierania, BPO mają najwyższy wskaźnik ścierania spośród wszystkich branż, a firmy muszą zatrudniać połowę siły roboczej każdego roku.

• Zwiększone regulacje i kontrole: Outsourcing rynku finansowego

Na przykład outsourcing kluczowych zadań nadzorczych przez globalne banki (brytyjskie giganty HSBC i Standard Chartered) do Indii znalazł się pod kontrolą audytora regulacyjnego w krajach goszczących pod kątem nieskutecznej kontroli podejrzanych transakcji finansowych. Praca wykonana przez inny zestaw ludzi w innym miejscu nie spowoduje żadnej transformacji procesu. Inkrementalne inicjatywy Six Sigma nie przyniosą wiele w przypadku procesu, który już działa przy 99,5% umów SLA opracowanych w oparciu o proces ręczny. Z punktu widzenia outsourcerów czysty outsourcing bez znaczącej przebudowy procesów nie sprawi, że firmy będą bardziej wydajne i sprawne. Po udanej fali outsourcingu opartego na arbitrażach kosztowych kolejna fala będzie musiała zostać poprowadzona przez jakość i czas na uzyskanie przewagi rynkowej. Wymaga to dźwigni technologicznej i wiedzy specjalistycznej. Outsourcowie zaczynają przechodzić od modelu outsourcingu opartego wyłącznie na FTE do usług zarządzanych. Co ważniejsze, nalegają na zrozumienie i zobaczenie, w jaki sposób firmy BPO zastosują technologię i automatyzację w celu ulepszenia swoich procesów zlecanych na zewnątrz. Trwa idealna burza, w której klienci starają się ograniczyć dodatkowe koszty backoffice z powodu ciągłej presji budżetowej, podczas gdy dostawcy próbują stworzyć dodatkowe usługi i związane z nimi przychody. W analizie indyjskiego przemysłu offshoringowego analiza McKinsey stwierdza: "Innowacje będą kluczem do utrzymania, a nawet rozszerzenia ich udziału w rynku. Modele biznesowe, które nadal koncentrują się na niskich kosztach pracy, nie wystarczą ". Okazuje się, że w środowisku po recesji będzie istnieć ciągła presja na obniżanie kosztów i ulepszanie usług. Jak zauważono w wywiadzie dla magazynu Wharton Knowledge w 2009 r., Nigdy nie wierzyłem w długoterminową opłacalność czystego podejścia typu "lift and shift", które zdominowało przemysł BPO i nadal tak jest. O ile jednorazowa oszczędność kosztów wynikająca z arbitrażu kosztowego miała sens we wczesnych dniach, a być może nadal stanowi szybki pierwszy przystanek, pomysł po prostu przeniesienia procesów do innej lokalizacji, bez poprawy lub optymalizacji w razie potrzeby, nie ma sens na dłuższą metę. Przez kilka dziesięcioleci służył obu stronom bardzo dobrze, ale teraz nadszedł czas na fundamentalne przekształcenie branży BPO i ITES. Ostatnie postępy technologiczne stanowią okazję i wyzwanie, aby odkryć na nowo, w jaki sposób technologia jest wykorzystywana w celu zwiększenia wydajności i sprawności. To, czy firmy korzystające z usług BPO i usług informatycznych [ITES] będą w stanie je wykorzystać na swoją korzyść, dopiero się okaże. Obecnie rośnie konsensus, że marże w branży outsourcingu spadają. Przez ponad dekadę firmy outsourcingowe cieszyły się jednym z najwyższych poziomów rentowności w każdej branży, ale kombinacja sił przesuwa marże do poziomów bardziej typowych dla produktów i usług skodyfikowanych . Wiele firm BPO zmienia się na nowo, ostatecznie skupiając się na automatyzacji i zwiększonym wykorzystaniu technologii. Genpact wprowadził podejście Lean DigitalSM. Genpact dąży do umożliwienia dużym firmom przebudowy ich działań średnich i backoffice oraz uzyskania wymiernego wpływu, takiego jak wzrost, efektywność kosztowa i elastyczność biznesowa. "Lean Digital wprowadza nową erę w to, jak nasi klienci zbliżają się do transformacji cyfrowej - zmiana, która spowodowała przyjęcie tych metod w wielu naszych klientach bankowych, ubezpieczeniowych, produkcyjnych, naukach przyrodniczych i produktach konsumenckich, a także przyczyniła się do naszych inwestycji w tym stworzenie laboratorium innowacji w Dolinie Krzemowej w celu prototypowania i eksperymentowania z nimi "- powiedział Tiger Tyagarajan, prezes i dyrektor generalny Genpact. Firma Genpact ogłosiła niedawno strategiczne partnerstwo z RAGE Frameworks w celu połączenia sztucznej inteligencji z podejściem Lean DigitalSM, aby przesunąć granice automatyzacji w instytucjach finansowych. Podobnie Wipro spodziewa się, że inwestycje w automatyzację, sztuczną inteligencję (AI) i technologię cyfrową poprawią wydajność i spowodują zmniejszenie liczby pracowników o 30% w ciągu najbliższych trzech lat. Powielanie procesów obsługiwanych ręcznie było modne w firmach BPO. To zyskało na popularności, ponieważ duża część procesów BPO jest bardzo mechaniczna i wymaga wprowadzania danych do systemów klienckich. Chociaż roboty potrafią poradzić sobie z takimi procesami mechanicznymi, automatyzacja robotów nie jest długoterminowym rozwiązaniem zwiększającym zwinność i elastyczność na bardziej podstawowym poziomie procesów biznesowych. Davenport przewiduje, że z biegiem lat pojawi się szeroki zestaw standardów procesowych, które zapewnią miary i przejrzystość niezbędne do oceny, czy outsourcing będzie korzystny i ułatwi porównywanie usługodawców. Ta linia dyskursu nie uwzględnia transformacyjnego wpływu najnowszych technologii. W rzeczywistości zakłada, że technologia nadal nie będzie odpowiadać na potrzeby biznesowe. Chociaż opracowywanie oprogramowania oparte na standardach ułatwiło tworzenie niezawodnego oprogramowania, nie zmieniło ono szybkości, z jaką oprogramowanie jest opracowywane, i jego reakcji na potrzeby biznesowe. W nadchodzącym dziesięcioleciu sam proces tworzenia oprogramowania zmieni się diametralnie, powodując zwrot w podejściu firm do tworzenia oprogramowania oraz, co ważniejsze, co zlecają i jak zlecają. Wierzymy, że technologia transformacyjna pozwoli firmie inteligentnie zdecydować, które procesy, jeśli w ogóle, powinny zostać zlecone na zewnątrz, i bezproblemowo zintegrować procesy outsourcingowe z pozostałymi procesami firmy. Elastyczność, z jaką technologia ułatwi wykonywanie procesów biznesowych, może pozwolić firmom na posiadanie nawet nie-podstawowych procesów, jeśli dostrzegą w tym pewne korzyści. Taka transformacyjna technologia wprowadzi nową erę innowacji we wszystkich procesach, zarówno podstawowych, jak i innych.

ROLA TECHNOLOGII W WYDAJNOŚCI I ZWINNOŚCI

Technologia ma kluczowe znaczenie dla wydajności i sprawności. Historycznie zauważono znaczącą rolę, jaką technologia powinna odgrywać w umożliwianiu przedsiębiorstwom konkurencyjności. W ciągu ostatniej dekady i więcej stało się tak jeszcze bardziej dzięki ogromnemu rozwojowi Internetu i wzajemnym połączeniom firm na całym świecie.

Aktualne wyzwania związane z technologią

Technologia od dawna niesie obietnicę ułatwienia bardziej wydajnych i elastycznych sposobów prowadzenia działalności oraz umożliwienia konkurencyjnego zróżnicowania. Historycznie także każde duże przedsiębiorstwo obfitowało w kadrę kierowniczą, która jest głęboko sfrustrowana niezdolnością technologii do sprostania ich wymaganiom. Technologowie obwiniają technologie tworzenia aplikacji (AD), mimo że technologie AD znacznie się rozwinęły od pierwszych dni przetwarzania. Widzieliśmy poważne zmiany ewolucyjne w środowiskach programistycznych, architekturach i metodologiach w wyniku wiedzy zdobytej na każdym etapie ewolucji. Jednak mimo że dzisiejsze technologie AD stanowią wyraźną poprawę w stosunku do technologii sprzed 5 do 10 lat temu, pozostaje kilka podstawowych kwestii, takich jak czas wprowadzenia na rynek, potrzeba radzenia sobie z szybkimi zmianami środowisk i standardów technologicznych oraz dostępność wykwalifikowanych zasobów. Nastąpiła także poważna zmiana w środowisku AD od lat 90. XX wieku, a wiele aplikacji w pakiecie zyskało znaczną przyczepność. Jednak aplikacje te wymagały znacznych dostosowań i nie zapewniły elastyczności do użycia od razu po wyjęciu z pudełka. Dostosowania wymagają obszernego programowania i często zajmują nadmiernie dużo czasu. Wystąpiły również znaczne luki między takimi aplikacjami a sposobem prowadzenia działalności przez przedsiębiorstwa. Luka w aplikacjach pakietowych i potrzebach biznesowych wynika głównie z tego, że aplikacje te nie zostały zaprojektowane od samego początku zorientowane na proces. W większości przypadków firmy decydują się dostosować swoje procesy do sposobu budowania aplikacji lub dostosować aplikacje, co powoduje, że obietnica przyszłych aktualizacji jest nieważna. W ten sposób w przyszłości stanowią poważne obciążenie związane z utrzymaniem. Niemniej jednak większość z tych aplikacji nie zapewniła przedsiębiorstwom niezbędnej wydajności i sprawności.

Oprogramowanie BPM

Oprogramowanie do zarządzania procesami biznesowymi (BPM) pojawiło się w ostatnim dziesięcioleciu i później, aby wypełnić lukę między aplikacjami w pakiecie a potrzebami przedsiębiorstwa w zakresie procesów biznesowych. Początkowo pakiety BPM zapewniały obsługę wyjątków i funkcjonalność przepływu pracy. Jak sama nazwa wskazuje, BPM zdefiniowano jako zarządzanie projektowaniem i kontrolą procesów biznesowych (Leymann i Altenhuber, 1994). Rozróżniają między czasem projektowania a aspektami czasu wykonywania procesu biznesowego. Reijers (2003) definiuje BPM jako obszar projektowania i kontrolowania procesów biznesowych. Tradycyjne platformy zarządzania sprawami (CMF) oparte na platformie BPM zostały wprowadzone przez tradycyjnych dostawców BPM, aby skrócić czas wprowadzania produktów na rynek w oparciu o rozwiązania. CMF są gotowe do użycia, aby stworzyć unikalne niestandardowe rozwiązanie. CMF zalecono tam, gdzie pakiety rozwiązań nie są dostępne lub są uważane za nieodpowiednie ze względu na luki w wymaganiach, brak elastyczności i tym podobne. CMF oparte na platformie BPM różnią się od tradycyjnych bibliotek kodów wielokrotnego użytku lub spakowanych aplikacji komercyjnych, ponieważ są one generalnie sterowane modelami i polegają na silniku orkiestracji do sterowania wykonaniem. Wiele CMF wykonuje rozwiązanie bezpośrednio z metadanych, a nie z kodu generowanego z metadanych. Niektórzy dostawcy zbudowali specyficzne dla domeny ramy pionowe na CMF, takie jak operacje call center. Chociaż istnieje duża liczba dostawców oprogramowania BPM oferujących CMF, są one jednak w stanie obsłużyć tylko przebieg sprawy. Ponieważ większość tych pakietów nie została zaprojektowana od samego początku zorientowaniem na proces, upłynie trochę czasu, zanim będą w stanie osiągnąć drobnoziarnistą elastyczność w celu zaspokojenia dynamicznego charakteru potrzeb biznesowych. Z tego powodu nikt nie był w stanie skutecznie rozwiązać podstawowych problemów związanych z elastycznością i czasem wprowadzenia na rynek w powiązanych wysiłkach związanych z opracowywaniem aplikacji. Każdy projekt oparty na platformach BPM nadal nie jest niedrogi, szybki ani elastyczny, chyba że pasuje do gotowego rozwiązania oferowanego przez dostawcę oprogramowania BPM, a bardzo rzadko jest ściśle dopasowany. Niezmiennie, biorąc pod uwagę gruboziarniste wsparcie procesu biznesowego przez wszystkie obecne platformy BPM, wdrożenie pełnego projektu zazwyczaj wymaga dużej ilości konwencjonalnego programowania. Oczywiście wynikiem jest długi cykl wdrażania i brak elastyczności. W ostatnim przykładzie, w którym globalna instytucja finansowa potrzebowała kompleksowej aplikacji do obsługi pożyczek dla nowej linii produktów kredytowych, szacunki dotyczące początkowego wdrożenia przez wiodących dostawców usług IT korzystających z wiodących na rynku platform BPM, w tym tych z CMF, wynosiły od 18 do 24 miesięcy. Analiza wymagań ujawnia, że dostawcy BPM z ich bieżącym, gruboziarnistym wsparciem dla procesów biznesowych obsłużyliby jedynie 10-15% całkowitej funkcjonalności systemu. Resztę należałoby opracować przy użyciu współczesnych metod tworzenia oprogramowania. W tym przykładzie aplikacji typu greenfield czas na wprowadzenie na rynek wyzwań, nawet przy użyciu BPMS, był wynikiem braku funkcjonalności, która może obsłużyć pełne spektrum potrzeb dla tej aplikacji. Do tego dochodzi brak myślenia procesowego w projektowaniu takich BPMS. Oczywiście, przy wsparciu tylko 10-15% aplikacji, projekt nie mógł zyskać znaczącego czasu na wprowadzenie na rynek ani korzyści z elastyczności. Inną ważną kwestią do zapamiętania jest to, że BPM nie wpływają na analizę wymagań lub etapy testowania cyklu tworzenia oprogramowania. Oba są bardzo czasochłonne dla całego projektu, bez względu na zastosowaną metodologię, co omówimy w dalszej części.

Rola metodologii

Cykl życia oprogramowania (SDLC) ewoluował od sztuki idiosynkratycznej do dyscypliny inżynierskiej. Dni nauki sztuki od mistrza rzemieślnika oddały strukturę, standardy i dyscypliny podobne do inżynierii. SDLC składa się z wielu etapów, gdy pomysł przekształca się w aplikację. Na każdym etapie wyniki z poprzedniego etapu są tłumaczone, aby służyły celowi i odbiorcom obecnego etapu. Te pośrednie tłumaczenia są konieczne, aby ostatecznie stworzyć tłumaczenie, na którym komputer może działać. Z każdym tłumaczeniem staramy się zachować pełną informację i wiedzę z poprzedniego etapu. Oczywiście każdy etap dodaje cennego czasu do całego cyklu życia. Niektóre etapy wymagają specjalistycznych umiejętności, takich jak programowanie. Przez lata włożono wiele wysiłku w uczynienie SDLC skutecznym i przewidywalnym. Takie wysiłki można podzielić na dwie główne kategorie:

• Podejścia metodologiczne mające na celu poprawę komunikacji i tłumaczenia między poszczególnymi etapami cyklu życia poprzez ich standaryzację i ograniczenie nadmiarowości w pracach programistycznych.

• Podejścia automatyzacji mające na celu automatyzację jednego lub więcej etapów cyklu.

Nacisk na podejście metodologiczne podniósł SDLC do nauk inżynieryjnych i ogólnie zwiększył przewidywalność i niezawodność tworzenia oprogramowania. Metodologie te jednak w dużej mierze nie uwzględniły kwestii czasu na rynku i kwestii elastyczności. Wynika to z tego, że przyjęli SDLC zorientowane na przyszłość, jak podano.

Zwinność Nie równa się zwinności

Niedawno wydaje się, że metodyki zwinne zyskują na popularności. Wszystkie metodologie Agile, luźniej mówiąc, są krótszymi wersjami powyższej współczesnej metodologii. W dużej mierze wynikają one ze świadomości, że wymagania zmieniają się często i nie są często precyzyjne. Aby zaradzić takiej zmienności w procesie i zmniejszyć koszty odkrywania luk znacznie poniżej bieżącego etapu, metody zwinne zalecają krótsze iteracje i kładą mniejszy nacisk na etapy statyczne, takie jak dokumentacja. Zwinne projekty zaczynają się od frazy dotyczącej planowania wydania, po której następuje kilka iteracji, z których każda kończy się testem akceptacyjnym dla użytkownika. Gdy produkt spełnia minimalnie wykonalny zestaw funkcji, zostaje zwolniony. Użytkownicy piszą "historie użytkowników", aby opisać pożądaną funkcjonalność. Takie historie stanowią wymagania stosowane do oszacowania realizacji projektu. Wykonanie jest podzielone na tyle iteracji, ile potrzeba. Użytkownicy mogą dodawać więcej szczegółów do swoich historii, nawet w trakcie iteracji. Zmiany przyrostowe są uwzględniane w następnej iteracji. Pod koniec każdej iteracji użytkownicy testują aplikację, a błędy są po prostu częścią kolejnej iteracji. Użytkownicy mogą w dowolnym momencie zdecydować o wydaniu oprogramowania, jeśli dostępna jest wystarczająca liczba funkcji. Ważnymi różnicami filozoficznymi jest uznanie, że wymagania nie są statyczne oraz że niektóre kroki, takie jak pełna dokumentacja wymagań, są niepotrzebne i przeciągają proces w dół. Sukces Agile zależy od ciągłego posiadania eksperta od wymagań. Wynika to z tego, że historie użytkowników są bardzo krótkie. Metodologia opiera się w coraz większym stopniu na dokumentacji. Metodologie zwinne, pomimo tego, co można interpretować na podstawie nazwy, nie powodują znaczącego skrócenia czasu wprowadzenia produktu na rynek ani elastyczności. W rzeczywistości, podobnie jak w przypadku wszystkiego nowego, widzimy znaczne nieporozumienie co do metodologii Agile. Metodyki zwinne powinny znacznie zwiększyć prawdopodobieństwo akceptacji przez użytkowników, ponieważ użytkownicy często zobaczą małe fragmenty aplikacji i będą mieli możliwość wprowadzania modyfikacji przez cały czas. Jeśli na czele stoi prawdziwe MŚP, prawdopodobne jest nieznaczne skrócenie czasu wprowadzenia produktu na rynek w porównaniu z konwencjonalnym SDLC. Częściej niż nie, przewidujemy, że metody zwinne zwiększą czas opracowania aplikacji. Pamiętaj, że istnieje kilka kroków niepowodujących wartości dodanej, takich jak testowanie, które będą musiały być wykonywane bardziej powtarzalnie w porównaniu ze środowiskiem innym niż Agile. Zwinne nie oznacza więc zwinności. Jest to krytyczny wniosek, który przedsiębiorstwa muszą internalizować. I nie zajmuje się podstawowymi kwestiami czasu na rynku i elastyczności. Jest realistycznie prawdopodobne, że wpłynie tylko na niezawodność. Pomimo znacznego nacisku na poprawę cyklu życia oprogramowania (SDLC), żadne z tych podejść nie spowodowało znaczącej różnicy w odwiecznych kwestiach czasu na rynku i elastyczności. Co ważniejsze, odsetek niepowodzeń lub ogromnych przekroczeń kosztów projektów oprogramowania jest wciąż niedopuszczalnie wysoki

NOWY PARADYGMAT TECHNOLOGII DLA WYDAJNOŚCI I ZWINNOŚCI

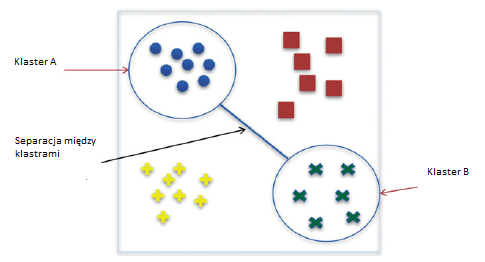

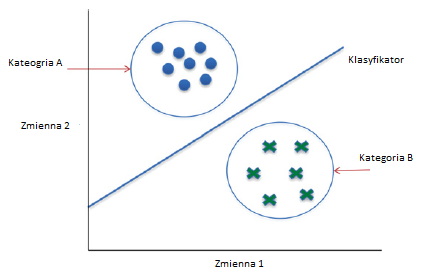

Istnieją znaczące dowody na korzyści płynące z zorientowania na proces w porównaniu z czysto funkcjonalnymi organizacjami. Mimo to przedsiębiorstwom trudno jest w praktyce zorientować się na proces. Zauważyliśmy również, że technologia może odgrywać kluczową rolę w umożliwianiu przedsiębiorstwom zorientowania na procesy bez konieczności zarządzania wieloma zmianami. W tym momencie przedstawimy platformę technologiczną i metodologię, która może zająć się chronicznym czasem wprowadzenia na rynek i problemami z elastycznością oraz umożliwić firmom uzyskanie zarówno wydajności, jak i sprawności. Omawiamy platformę automatyzacji procesów biznesowych opartą na modelu meta, która może umożliwić tworzenie oprogramowania w czasie zbliżonym do rzeczywistego w dużej mierze bez programowania i wyłącznie przy użyciu metadanych.

Technologia i architektura zorientowana na proces

Zaczynamy od nakreślenia wysokiego poziomu koncepcyjnego związku między biznesem zorientowanym na proces a technologią. Zależność pokazano poniżej

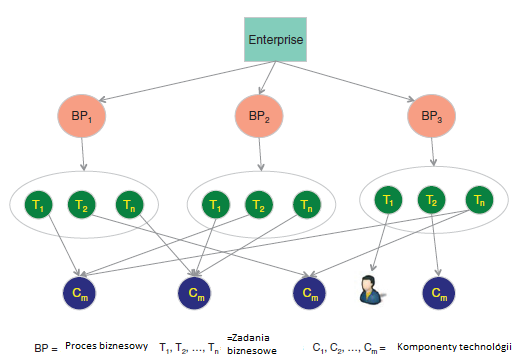

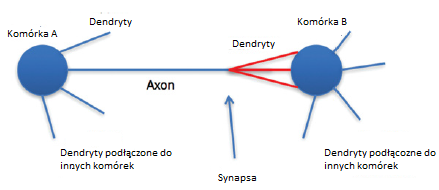

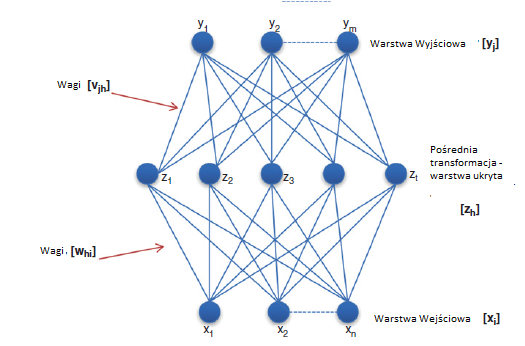

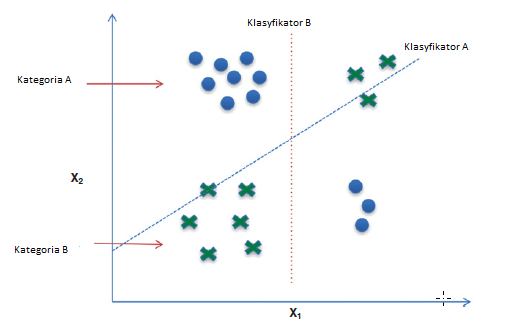

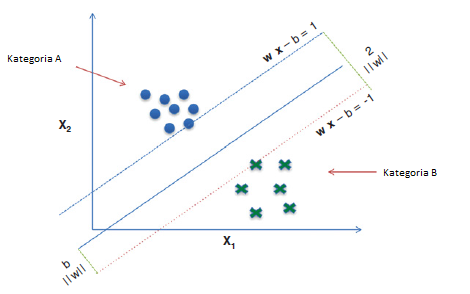

Rycina przedstawia hipotetyczny biznes. Jest on konceptualizowany jako zbiór procesów biznesowych, dlatego należy go postrzegać [BP1, BP2, BP3,

, BPm]. Możemy dalej myśleć o każdym procesie biznesowym jako o zestawie zadań biznesowych. Proces biznesowy to zestaw powiązanych ze sobą zadań, które są wykonywane w określonej kolejności przez połączenie ludzi i maszyn [T1, T2,