Wprowadzenie

KROK 1

Wprowadzenie do Big Data Analytics

CO TO JEST BIG DATA?

Big Data to dowolna duża ilość danych ustrukturyzowanych, częściowo ustrukturyzowanych i nieustrukturyzowanych, które mogą zostać wydobyte w celu uzyskania informacji, w których indywidualne rekordy przestają mieć znaczenie i tylko agregują je. Dane stają się Big Data, gdy przetwarzanie ich przy użyciu tradycyjnych technik jest trudne.

CHARAKTERYSTYKA BIG DATA:

Istnieje wiele cech Big Data. Omówmy kilka tutaj.

1. Objętość: duże zbiory danych oznaczają ogromne ilości danych generowanych przez czujniki, maszyny połączone z eksplozją internetu, media społecznościowe, handel elektroniczny, urządzenia GPS itp.

2. Prędkość: implikuje szybkość, z jaką napływają dane, tak jak użytkownicy Facebooka generują 3 miliony polubień dziennie, a użytkownicy tworzą około 450 milionów tweetów dziennie.

3. Różnorodność: sugeruje rodzaj formatów i można je podzielić na 3 typy:

- Strukturalne - RDBMS, takie jak Oracle, MySQL, starsze systemy, takie jak Excel, Access

- Półustrukturyzowane - e-maile, tweety, pliki dziennika, opinie użytkowników

- Nieustrukturyzowane - zdjęcia, wideo, pliki audio.

4. Wiarygodność: Odnosi się do stronniczości, szumu i nieprawidłowości w danych. Jeśli chcemy uzyskać znaczący wgląd w te dane, musimy je wstępnie oczyścić.

5. Ważność: Odnosi się do adekwatności i precyzji danych, ponieważ ważność danych jest bardzo ważna przy podejmowaniu decyzji.

6. Zmienność: Odnosi się do tego, jak długo dane są ważne, ponieważ dane, które są obecnie aktualne, mogą nie być ważne zaledwie kilka minut lub dni później.

DLACZEGO BIG DATA JEST WAŻNE?

Sukces organizacji polega nie tylko na tym, jak dobrze radzi sobie w prowadzeniu działalności, ale także na tym, jak dobrze może analizować swoje dane i uzyskiwać wgląd w swoją firmę, konkurentów itp. Duże zbiory danych mogą pomóc ci w podjęciu właściwej decyzji we właściwej decyzji czas. Dlaczego nie RDBMS? Skalowalność jest głównym problemem w RDBMS, bardzo trudno jest zarządzać RDBMS, gdy zmieniają się wymagania lub liczba użytkowników. Kolejny problem z RDBMS polega na tym, że musimy zdecydować o strukturze bazy danych na początku, a późniejsze wprowadzanie jakichkolwiek zmian może być ogromnym zadaniem. W przypadku dużych zbiorów danych potrzebujemy elastyczności i niestety RDBMS nie może tego zapewnić.

TERMINOLOGIA ANALITYCZNA

Analityka to jedno z niewielu pól, w którym wiele różnych terminów jest rozpowszechnianych przez wszystkich i wiele z nich brzmi podobnie, ale są one używane w różnych kontekstach. Niektóre terminy brzmią bardzo odmiennie, ale są podobne i można je stosować zamiennie. Ktoś, kto nie zna się na Analityce, spodziewał się pomylić z bogactwem terminologii dostępnej w tej dziedzinie. Analityka to proces dzielenia problemu na prostsze części i korzystania z wnioskowania na podstawie danych w celu podejmowania decyzji. Analityka nie jest narzędziem ani technologią, a raczej sposobem myślenia i działania. Business Analytics określa zastosowanie Analityki w sferze biznesu. Obejmuje analizę marketingową, analizę ryzyka, analizę oszustw, analizę CRM, analizę lojalności, analizę operacji, a także analizę HR. W ramach działalności Analityka jest wykorzystywana we wszystkich branżach, takich jak analityka finansowa, analityka zdrowotna, analityka detaliczna, analityka telekomunikacyjna, analityka internetowa. Analityka predykcyjna zyskała na popularności w ostatnich latach vs. retrospektywna natura, taka jak OLAP i BI, Analiza opisowa polega na opisywaniu lub eksploracji dowolnego rodzaju danych. Eksploracja i przygotowanie danych jest niezbędne, aby w dużym stopniu polegać na analizie opisowej. Big Data Analytics to nowy termin używany do analizy nieustrukturyzowanych danych i dużych danych, takich jak terabajty, a nawet petabajty danych. Big Data to dowolny zestaw danych które nie mogą być analizowane za pomocą konwencjonalnych narzędzi.

RODZAJE ANALITYKI

Analitykę można zastosować do tak wielu problemów i w wielu różnych branżach, że ważne jest, aby poświęcić trochę czasu na zrozumienie zakresu analiz w biznesie. Przyjrzymy się bliżej 3 szerokim klasyfikacjom analitycznym: 1. W oparciu o branżę. 2. W oparciu o funkcję biznesową. 3. W oparciu o rodzaj oferowanych spostrzeżeń. Zacznijmy od spojrzenia na branże, w których wykorzystanie analizy jest bardzo powszechne. Istnieją pewne branże, które zawsze tworzyły ogromną ilość danych, takie jak karty kredytowe i towary konsumpcyjne. Branże te były jednymi z pierwszych, które wprowadziły analizy. Analityka jest często klasyfikowana na podstawie branży, do której jest stosowana, dlatego usłyszysz takie terminy, jak analizy ubezpieczeniowe, analizy detaliczne, analityka internetowa i tak dalej. Możemy nawet sklasyfikować analitykę na podstawie funkcji biznesowej, w której jest używana. Klasyfikacja analityki na podstawie funkcji biznesowej i wpływu wygląda następująco:

- Analityka marketingowa

- Analizy sprzedaży i HR

- Analizy łańcucha dostaw i tak dalej

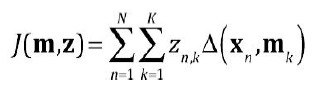

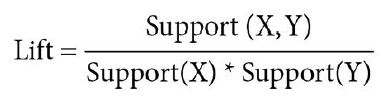

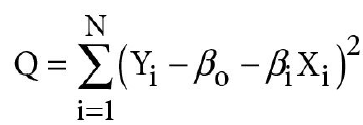

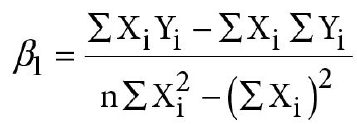

Może to być dość długa lista, ponieważ analiza ma wpływ na praktycznie każdą działalność biznesową w dużej organizacji. Ale najbardziej popularny sposób klasyfikowania analiz opiera się na tym, co pozwala nam to zrobić. Wszystkie informacje są gromadzone dla różnych branż i różnych działów. Wszystko, co musimy zrobić, to kroić i kroić dane na różne sposoby, być może patrząc na nie pod różnymi kątami lub wzdłuż różnych wymiarów itp. Jak widać analiza opisowa jest prawdopodobnie najprostszym rodzajem analizy, ponieważ wykorzystuje istniejące informacje z przeszłości, aby zrozumieć decyzje w teraźniejszości i miejmy nadzieję, że pomoże zdecydować o skutecznym źródle działania w przyszłości. Jednak ze względu na względną łatwość zrozumienia i opisową analizę analityczną często uważano za stonowanego bliźniaka analityki. Ale jest również niezwykle potężna pod względem potencjału i w większości sytuacji biznesowych, analiza opisowa może pomóc rozwiązać większość problemów. Detaliści są bardzo zainteresowani zrozumieniem relacji między produktami. Chcą wiedzieć, czy dana osoba kupuje produkt A, czy prawdopodobnie kupuje również produkt B lub produkt C. Nazywa się to analizą powinowactwa produktu lub analizą skojarzeń i jest powszechnie stosowane w branży detalicznej. Nazywa się to również analizą koszyka rynkowego i jest używane w odniesieniu do zestawu technik, które można zastosować do analizy koszyka zakupów lub transakcji. Czy zastanawiałeś się kiedyś, dlaczego mleko jest umieszczane z tyłu sklepu, a magazyny i guma do żucia znajdują się przy kasie? Wynika to z faktu, że za pośrednictwem detalistów analitycznych zdajesz sobie sprawę, że podczas podróży na tył sklepu, aby odebrać niezbędne rzeczy, możesz po prostu pokusić się o coś innego, a także dlatego, że czasopisma i guma do żucia są tanimi zakupami impulsowymi. Postanawiasz wrzucić je do koszyka, ponieważ nie są zbyt drogie i prawdopodobnie patrzyłeś na nie, czekając w kolejce przy kasie. Analiza predykcyjna działa poprzez identyfikację wzorców i danych historycznych, a następnie użycie statystyki, aby wyciągać wnioski na temat przyszłości. Na bardzo uproszczonym poziomie staramy się dopasować dane do określonego wzorca, a jeśli uważamy, że dane są zgodne z określonym wzorcem, możemy przewidzieć, co stanie się w przyszłości. Spójrzmy na inny przykład dotyczący analizy predykcyjnej w branży telekomunikacyjnej. Duża firma telekomunikacyjna ma dostęp do wszelkiego rodzaju informacji o nawykach telefonicznych klienta:

- Ile czasu spędzają na telefonie?

-Ile połączeń międzynarodowych wykonują?

- Czy wolą numery SMS lub połączenia poza swoim miastem?

Jest to informacja, którą można uzyskać wyłącznie poprzez obserwację lub analizę opisową. Ale takie firmy, co ważniejsze, chciałyby wiedzieć, którzy klienci planują odejść i nawiązać nowe połączenie ze swoimi konkurentami. Wykorzysta tu informacje historyczne, ale w celu uzyskania wyników wykorzysta modelowanie i analizę predykcyjną. To jest analiza predykcyjna. Chociaż analiza opisowa jest bardzo potężnym narzędziem nadal daje nam informacje tylko o przeszłości, podczas gdy w rzeczywistości główną troską większości użytkowników zawsze będzie przyszłość. Właściciel hotelu chciałby przewidzieć, ile jego pokoi będzie zajmowanych w przyszłym tygodniu. Dyrektor generalny firmy Pharma będzie chciał wiedzieć, który z jego testowanych leków najprawdopodobniej odniesie sukces. W tym przypadku analizy predykcyjne są o wiele bardziej przydatne. Oprócz tych narzędzi istnieje trzeci rodzaj analiz, który powstał bardzo niedawno, być może zaledwie dziesięć lat temu. Nazywa się to analizą nakazową. Analizy preskryptywne wykraczają poza analitykę predykcyjną, mówiąc nie tylko o tym, co się dzieje, ale także o tym, co może się wydarzyć, a co najważniejsze, co z tym zrobić. Może również informować o wpływie tych decyzji, co sprawia, że analiza nakazowa jest tak nowoczesna. Domeny biznesowe, które są świetnymi przykładami, w których można zastosować nakazową analizę, to przemysł lotniczy lub ogólnokrajowe sieci drogowe. Preskryptywne analizy mogą przewidzieć skutecznie korygujące wąskie gardła na drogach lub zidentyfikować drogi, na których można wprowadzić opłaty za przejazd w celu usprawnienia ruchu. Aby zobaczyć, jak funkcjonuje analiza nakazowa w branży lotniczej, spójrzmy na następujący przykład. Linie lotnicze zawsze szukają sposobów na optymalizację swoich tras w celu uzyskania maksymalnej wydajności. Mogą to być miliardy dolarów oszczędności, ale nie jest to takie łatwe. Przy ponad 50 milionach lotów komercyjnych na świecie co roku, jest to lot co sekundę. Prosta trasa lotu między dwoma miastami, powiedzmy, San Francisco i Bostonem, ma 2000 opcji trasy. Dlatego branża lotnicza często polega na nakazowej analizie, która decyduje o tym, co, kto i jak powinien latać samolotem, aby obniżyć koszty i zyski. Przyjrzeliśmy się zatem dość dogłębnej analizie opisowej, predykcyjnej i nakazowej. Celem tego kursu będzie analiza opisowa. Pod koniec poświęcimy trochę czasu na zrozumienie niektórych bardziej popularnych technik modelowania predykcyjnego.

CYKL ŻYCIA ANALITYKI

Cykl życia Analityki ma różne etapy i wiele osób opisuje go na wiele sposobów, ale ogólny pomysł pozostaje taki sam. Rozważmy następujące etapy cyklu życia projektu Analityki.

- Identyfikacja problemu

- Formułowanie hipotez

- Zbieranie danych

- Eksploracja danych

- Przygotowanie danych / manipulacja

- Planowanie modelu / budowanie

- Sprawdenie poprawności modelu

- Oceń / Monitoruj wyniki

1. Identyfikacja problemu: Problem to sytuacja, która jest oceniana jako coś, co wymaga naprawy. Naszym zadaniem jest upewnienie się, że rozwiązujemy odpowiedni problem, może nie być to ten przedstawiony nam przez klienta. Co naprawdę musimy rozwiązać? Czasami stwierdzenia problemów, które otrzymujemy od firmy, są bardzo proste.

Na przykład:

- Jak zidentyfikować najcenniejszych klientów?

- W jaki sposób mogę zminimalizować straty wynikające z braku dostępności produktu na półce?

- Jak zoptymalizować mój ekwipunek?

- Jak wykryć klientów, którzy prawdopodobnie nie wykonają płatności rachunków?

Są to proste stwierdzenia problemów i naprawdę nie ma wątpliwości co do tego, co próbujemy osiągnąć dzięki projektowi analitycznemu. Jednak za każdym razem nasze oświadczenie biznesowe może nie prowadzić do jednoznacznej identyfikacji problemu. Czasami oświadczenia biznesowe są na bardzo wysokim poziomie, dlatego będziesz musiał spędzić czas z firmą, aby zrozumieć potrzeby i uzyskać kontekst. Konieczne może być podzielenie tego problemu na podproblemy w celu zidentyfikowania krytycznych wymagań. Być może trzeba pomyśleć o ograniczeniach, które należy uwzględnić w rozwiązaniu. Przypuśćmy, że pracujesz dla firmy obsługującej karty kredytowe, a firma mówi ci, że jest problem, na który chcą spojrzeć, a mianowicie: "Chcemy otrzymywać wnioski o kartę kredytową tylko od dobrych klientów" . Teraz z perspektywy biznesowej, czy jest to prawidłowe oświadczenie biznesowe? Z pewnością na bardzo wysokim poziomie jest to ważny wymóg biznesowy. Czy jednak dla twojego celu, jakim jest zbudowanie rozwiązania mającego na celu rozwiązanie tego pytania, jest to bardzo ważne stwierdzenie, czy wystarczający punkt wyjścia do analizy danych? Nie. Ponieważ z takim oświadczeniem biznesowym jest wiele problemów. Co to znaczy, że chcemy otrzymywać wnioski o kartę kredytową tylko od dobrych klientów? Spójrzmy na problem z tym stwierdzeniem problemu. Chcę otrzymywać wnioski o kredyt wyłącznie od dobrych klientów. Jednym z najbardziej oczywistych problemów związanych z tym stwierdzeniem jest to, kim są dobrzy klienci? Jeśli masz wiedzę na temat branży kart kredytowych, jedną z odpowiedzi dla dobrego klienta mogą być ludzie, którzy nie zwlekają z płatnościami. Oznacza to, że wydajesz na kartę kredytową i spłacasz jej kartę kredytową na czas. Jednak inną definicją dobrego klienta mogą być ludzie, którzy nie płacą na czas. Dlaczego? Ponieważ jeśli nie zapłacisz na czas, wystawca karty kredytowej może obciążyć Cię wysokimi stopami procentowymi od tego salda na karcie kredytowej. Tego rodzaju klienci nazywani są rewolwerami. Kto naprawdę jest dobrym klientem dla firmy wydającej karty kredytowe? Czy ci klienci płacą na czas? Czy są to klienci, którzy nie wywiązują się ze zobowiązań i nie płacą na czas. Odpowiedź może być taka ,że obaj są dobrymi klientami. Jak to możliwe? To zależy od twojej perspektywy. Jeśli chcesz zminimalizować ryzyko, jeśli pracujesz w dziale ryzyka firmy wydającej karty kredytowe, Twoją definicją dobrego klienta są klienci, którzy płacą na czas, klienci, którzy wywiązują się ze zobowiązań. Jeśli natomiast patrzysz na przychody, to dobrym pomysłem na dobrego klienta mogą być ludzie, którzy dużo wydają na kartę kredytową i nie zwracają jej całej. Mają wysoką równowagę obrotową. Teraz, jako analityk, kto decyduje, kim są dobrzy klienci? Gdy wystawca karty kredytowej wyda Ci wyciąg biznesowy, który mówi, że chcemy przyjąć wniosek o kartę kredytową tylko od dobrych klientów. Czy wiesz, że szukają ryzyka lub przychodów? To naprawdę zależy od interesów biznesowych; zależy to od celów biznesowych na ten rok. W rzeczywistości dobry klient w tym roku może być złym klientem w przyszłym roku. Dlatego ważne jest, aby uzyskać kontekst lub opis problemu przed rozpoczęciem analizy. Ale to nie jedyny problem z tym opisem problemu. Innym problemem jest zastanowienie się nad decyzją: czy naprawdę możesz nalegać na otrzymywanie dobrych aplikacji lub czy możesz nalegać na zatwierdzanie dobrych aplikacji. Czy decyzja jest na etapie składania wniosku lub zatwierdzania? Czy naprawdę możesz kontrolować aplikacje, aby były dobre, czy możesz kontrolować decyzje, aby umożliwić dostęp do ciebie tylko dobrym klientom?. Innym problemem związanym z tym opisem problemu jest to, że chcemy otrzymywać wnioski o karty kredytowe tylko od dobrych klientów. Czy realistyczne jest zakładanie, że będziesz mieć rozwiązanie, które nigdy nie przyjmie złego klienta?

Ponownie, nie jest to realistyczny wynik. Wracając do naszego stanu definicji problemu, którym jest problem biznesowy, chcę uzyskać dobrych klientów jako wystawca kart kredytowych. Jak przekształcić ten problem w coś, co może rozwiązać podejście analityczne? Jednym ze sposobów jest dodanie szczegółów do opisu problemu. Pomyśl więc o konkretnych, wymiernych, osiągalnych, realistycznych i terminowych wynikach, które możesz dołączyć do tego opisu problemu. Dlatego podkreślamy, że musisz dokładnie zrozumieć kontekst biznesowy i porozmawiać czy masz do czynienia z właściwym problemem. Jak mogę dodać szczegóły do tego problemu? Załóżmy, że patrzę na to z perspektywy ryzyka, ponieważ w tym roku moje firmy wydające karty kredytowe skupiły się na zmniejszeniu ryzyka portfela. Mógłbym mieć różne oświadczenia o problemach biznesowych. Na przykład zmniejsz straty z domyślnej karta kredytowa o co najmniej 30 procent w ciągu pierwszych 12 miesięcy po wdrożeniu nowej strategii. Opracuj algorytm do sprawdzania aplikacji, które nie spełniają kryteriów określonych przez klienta, co zmniejszy domyślne wartości o 20 procent w ciągu najbliższych 3 miesięcy. Zidentyfikuj strategie ograniczenia domyślnych zobowiązań o 20 procent w ciągu najbliższych trzech miesięcy, umożliwiając zagrożonym klientom dodatkowe opcje płatności. Zdecydowaliśmy, że dobrą definicją problemu zajmujemy się z perspektywy ryzyka. Ale w przypadku tego samego oświadczenia biznesowego mamy teraz trzy różne oświadczenia dotyczące problemów, które dotyczą trzech różnych rzeczy. Znowu, który z nich powinienem wybrać jako punkt wyjścia do mojej analizy? Czy powinienem identyfikować strategie dla moich obecnych klientów, czy powinienem szukać potencjalnych nowych klientów? Ponownie jest to coś, co może wynikać z potrzeb biznesowych. Dlatego ważne jest, aby stale rozmawiać z biznesem, aby upewnić się, że rozpoczynając projekt analityczny, rozwiązujesz właściwe stwierdzenie problemu. Dotarcie do jasno zdefiniowanego problemu jest często oparte na odkryciach - zacznij od definicji pojęciowej, a poprzez analizę (pierwotną przyczynę, analizę wpływu itp. kształtujesz i redefiniujesz problem pod względem zagadnień. Problem staje się znany, gdy dana osoba widzi rozbieżność między tym, jakie rzeczy są i tym, jakie powinny być. Problemy mogą być zidentyfikowane przez:

- Badania porównawcze / porównanie

- Raportowanie wyników - ocena bieżących wyników w stosunku do celów i założeń

- Analiza SWOT - ocena mocnych stron, słabości, szans i zagrożeń

- Skargi / ankiety

Czasami to, co uważamy za problem, nie jest prawdziwym problemem, więc aby dojść do prawdziwego problemu, konieczne jest sondowanie. Analiza przyczyn pierwotnych jest skuteczną metodą sondowania - pomaga zidentyfikować, co, jak i dlaczego coś się wydarzyło. Rozważmy wzrost rotacji pracowników w naszej organizacji. Musimy dowiedzieć się czemu Pięć Razy Dlaczego odnosi się do praktyki pytania pięć razy, dlaczego problem istnieje, aby dotrzeć do jego pierwotnej przyczyny:

- Dlaczego pracownicy wyjeżdżają do innej pracy?

- Dlaczego pracownicy nie są zadowoleni?

- Dlaczego pracownicy uważają, że są niedopłacani?

- Dlaczego inni pracodawcy płacą wyższe pensje?

- Dlaczego popyt na takich pracowników wzrósł na rynku?

Podstawowe pytania do zdefiniowania problemu:

- Kto powoduje problem?

- Kogo dotyczy ten problem?

- Co się stanie, jeśli ten problem nie zostanie rozwiązany? Jakie są skutki?

- Gdzie i kiedy występuje ten problem?

- Dlaczego występuje ten problem?

- Jak powinien działać proces?

- Jak ludzie obecnie radzą sobie z problemem?

2. Formułowanie hipotezy: Rozbij problemy i formułuj hipotezy. Określ ramy pytań, na które należy odpowiedzieć, lub tematów, które należy zbadać, aby rozwiązać problem.

- Opracuj kompleksową listę wszystkich możliwych problemów związanych z problemem

- Ogranicz obszerną listę, eliminując duplikaty i łącząc nakładające się problemy

- Korzystając z budowania konsensusu, przejdź do listy głównych problemów.

3. Zbieranie danych: Aby odpowiedzieć na kluczowe pytania i zweryfikować hipotezy, konieczne jest zebranie realistycznych informacji. W zależności od rodzaju rozwiązywanego problemu można zastosować różne techniki gromadzenia danych. Zbieranie danych jest kluczowym etapem rozwiązywania problemów - jeśli jest powierzchowne, stronnicze lub niekompletne, analiza danych będzie trudna.

Techniki zbierania danych:

- Korzystanie z danych, które zostały już zebrane przez innych

- Systematycznie wybieraj i obserwuj cechy ludzi, przedmiotów lub wydarzeń.

- Ustne pytania respondentów, indywidualnie lub w grupie.

- Zbieranie danych na podstawie odpowiedzi udzielonych przez respondentów w formie pisemnej.

- Ułatwienie bezpłatnych dyskusji na wybrane tematy z wybraną grupą uczestników.

4. Eksploracja danych: Przed przeprowadzeniem formalnej analizy danych analityk musi wiedzieć, ile przypadków znajduje się w zbiorze danych, jakie zmienne są uwzględnione, ile jest brakujących obserwacji i jakie ogólne hipotezy dane mogą wesprzeć. Wstępna eksploracja zestawu danych pomaga odpowiedzieć na te pytania, zapoznając analityków z danymi, z którymi pracują. Analitycy często używają wizualizacji do eksploracji danych, ponieważ umożliwia ona użytkownikom szybkie i proste przeglądanie większości istotnych funkcji ich zbioru danych. W ten sposób użytkownicy mogą zidentyfikować zmienne, które mogą mieć interesujące obserwacje. Wyświetlając dane graficznie za pomocą wykresów rozrzutu lub wykresów słupkowych, użytkownicy mogą sprawdzić, czy dwie lub więcej zmiennych koreluje i ustalić, czy są dobrymi kandydatami do dalszej szczegółowej analizy.

5. Przygotowanie danych: Dane przychodzą do Ciebie w formie, która nie jest łatwa do analizy. Musimy wyczyścić dane i sprawdzić ich spójność, konieczna jest obszerna manipulacja danymi w celu ich analizy.

Etapy przygotowania danych mogą obejmować:

- Importowanie danych

- Identyfikacja zmiennych / Tworzenie nowych zmiennych

- Sprawdzanie i podsumowywanie danych

- Wybieranie podzbiorów danych

- Wybieranie zmiennych i zarządzanie nimi.

- Łączenie danych

- Dzielenie danych na wiele zestawów danych.

- Leczenie brakujących wartości

- Leczenie odstępne

Identyfikacja zmiennych: Najpierw zidentyfikuj zmienne predykcyjne (wejściowe) i docelowe (wyjściowe). Następnie określ typ danych i kategorię zmiennych.

Analiza jednoczynnikowa: Na tym etapie badamy zmienne jeden po drugim. Metoda przeprowadzania analizy jednoczynnikowej będzie zależeć od tego, czy typ zmiennej jest kategoryczny czy ciągły. Przyjrzyjmy się tym metodom i miarom statystycznym indywidualnie dla zmiennych jakościowych i ciągłych.

Ciągłe zmienne: W przypadku zmiennych ciągłych musimy zrozumieć centralną tendencję i rozprzestrzenianie się zmiennej. Są one mierzone przy użyciu różnych metod wizualizacji metryk statystycznych.

Zmienne jakościowe: W przypadku zmiennych jakościowych używamy tabeli częstotliwości, aby zrozumieć rozkład każdej kategorii. Możemy również odczytać jako procent wartości w każdej kategorii. Można to zmierzyć za pomocą dwóch wskaźników, liczby i procentu dla każdej kategorii.

6. Budowanie modelu: To tak naprawdę cały proces budowania rozwiązania i wdrażania rozwiązania. Większość czasu poświęconego na projekt spędza się na etapie wdrażania rozwiązania. Jedną z interesujących rzeczy, o których należy pamiętać przy podejściu analitycznym, jest to, że podejście analityczne podczas budowania modeli, modeli analitycznych, jest procesem bardzo iteracyjnym, ponieważ nie ma czegoś takiego jak ostateczne rozwiązanie lub idealne rozwiązanie. Zazwyczaj poświęcasz czas na budowanie wielu modeli na wielu rozwiązaniach, zanim znajdziesz najlepsze rozwiązanie, z którym firma będzie współpracować.

7. Istnieje wiele sposobów podejmowania decyzji z perspektywy biznesowej. Analityka to jeden sposób. Istnieją inne sposoby podjęcia decyzji. Może to być podejmowanie decyzji opartych na doświadczeniu. Może to być proces decyzyjny oparty na przeszukaniu. I nie za każdym razem zawsze wybierzesz podejście analityczne. Jednak na dłuższą metę sensowne jest budowanie zdolności analitycznych, ponieważ prowadzi to do bardziej obiektywnego podejmowania decyzji. Ale zasadniczo, jeśli chcesz danych, aby przyspieszyć podejmowanie decyzji, musisz upewnić się, że zainwestowałeś w gromadzenie odpowiednich danych, aby umożliwić Ci podejmowanie decyzji na podstawie danych

8. Ocena / monitorowanie modelu: Jest to ciągły proces mający na celu przede wszystkim sprawdzenie skuteczności rozwiązania w czasie. Pamiętaj, że analityczne podejście do rozwiązywania problemów różni się od standardowego podejścia do rozwiązywania problemów. Musimy pamiętać o tych punktach:

- Dane mają wyraźną pewność co do identyfikacji rozwiązania.

- Używamy technik analitycznych opartych na teoriach numerycznych.

- Musisz dobrze zrozumieć teoretyczne koncepcje sytuacji biznesowych, aby stworzyć realne rozwiązanie.

Oznacza to, że potrzebujesz dobrego zrozumienia sytuacji biznesowej i kontekstu biznesowego, a także silnej wiedzy na temat podejść analitycznych i umieć łączyć koncepcje, znaleźć praktyczne rozwiązanie. W niektórych branżach tempo zmian jest bardzo wysokie. Rozwiązania starzeją się więc bardzo szybko. W innych branżach tempo zmian może nie być tak wysokie, a kiedy zbudujesz rozwiązanie, możesz mieć rozwiązanie na 2-3 lata, które będzie działać, ale trzeba będzie dostosować, aby zarządzać nowymi warunkami biznesowymi. Jednak sposobem oceny, czy Twoje rozwiązanie działa, jest okresowe sprawdzanie skuteczności rozwiązania. Konieczne jest śledzenie niezawodności w czasie i może być konieczne wprowadzenie niewielkich zmian, aby przywrócić rozwiązanie na właściwe tory. Czasami może być konieczne zbudowanie całego rozwiązania od zera, ponieważ środowisko zmieniło się tak drastycznie, że zbudowane rozwiązanie nie łączy się już w obecnym kontekście biznesowym

WSPÓLNE BŁĘDY W ANALITYCZNYM MYŚLENIU

Definicja problemu przez klienta może być niepoprawna. Może mu brakować wiedzy i doświadczenia, które posiadasz. Ponieważ większość problemów nie jest unikalna, możemy potwierdzić problem i możliwe rozwiązania w stosunku do innych źródeł. Najlepsze rozwiązania problemu są często zbyt trudne do wdrożenia przez klienta. Zachowaj więc ostrożność w zalecaniu optymalnego rozwiązania problemu. Większość wyjaśnień wymaga pewnego stopnia ugody w celu wykonania.

KROK 2

Rozpoczęcie pracy z R

WPROWADZENIE

R jest językiem programowania do analizy statystycznej i raportowania. R jest prostym językiem programowania, który zawiera wiele funkcji do analizy danych, ma efektywne narzędzie do obsługi i przechowywania danych. R zapewnia graficzne możliwości analizy danych i raportowania. Proszę o zainstalowanie R and R studio, które można bezpłatnie pobrać.

Kiedy po raz pierwszy otworzysz Studio R, zobaczysz cztery okna.

1. Skrypty: Służy jako obszar do pisania i zapisywania kodu R.

2. Obszar roboczy: Wyświetla zestaw danych i zmienne w środowisku R.

3. Wykresy: Wyświetla wykresy wygenerowane przez kod R.

4. Konsola : Zapewnia historię wykonanego kodu R i danych wyjściowych

OPERACJE ELEMENTARNE W R

1. Wyrażenia:

Jeśli pracujesz tylko z liczbami R możesz użyć jako zaawansowanego kalkulatora, po prostu wpisz

4 + 5

i naciśnij enter, otrzymasz wartość 9.

R może wykonywać obliczenia matematyczne bez konieczności przechowywania go w obiekcie. Wynik jest wydrukowany na konsoli. Spróbuj obliczyć iloczyn 2 lub więcej liczb (* to operator mnożenia).

6 * 9 # otrzymasz 54.

Cokolwiek napisane po znaku # będzie uważane za komentarz w R.

R stosuje się do reguł BODMAS, aby wykonywać operacje matematyczne.

Wpisz następujące polecenia i zrozum różnicę.

20-15 * 2 # otrzymasz -10

(20-15) * 2 #uzyskasz 10

Uważaj, aby oddzielić dowolną wartość od 0, aby uzyskać inf (nieskończoność).

wpisz to polecenie w konsoli i sprawdź

8/0

Te operacje matematyczne można łączyć w długie formuły, aby osiągnąć określone zadania.

2. Wartości logiczne:

Niewiele wyrażeń zwraca "wartość logiczną": PRAWDA lub FAŁSZ. (znane jako wartości "boolowskie"). Spójrz na wyrażenie, które daje nam logiczną wartość:

6 < 9 # PRAWDA

3. Zmienne:

Możemy przechowywać wartości w zmiennej, aby uzyskać do niej dostęp później.

X <- 48 # do przechowywania wartości w x.

Y <- "YL, Prasad" (nie zapomnij cudzysłowów)

Teraz X i Y są obiektami utworzonymi w R, mogą być używane w wyrażeniach w pozycji oryginalnego wyniku. Spróbuj wywołać X i Y, wpisując nazwę obiektu

Y # [1] "YL, Prasad"

musimy pamiętać, że R rozróżnia małe i wielkie litery.Jeśli przypiszesz wartość do znaku X i wywołasz małe X, wyświetli się błąd. Spróbuj podzielić X przez 2 (/ jest operatorem dzielenia) # dostaniesz 24 jako odpowiedź Możemy ponownie przypisać dowolną wartość do zmiennej w dowolnym momencie. Przypisz "Lakshmi" do Y.

Y <- "Lakshmi"

Możemy wyświetlić wartość zmiennej po prostu wpisując jej nazwę w konsoli. Spróbuj wyświetlić bieżącą wartość Y. Jeśli napisałeś ten kod, gratulacje! Pierwszy kod napisałeś w R i stworzyłeś obiekt.

4. Funkcje

Możemy wywołać funkcję, wpisując jej nazwę, a następnie w nawiasie argumenty tej funkcji. Wypróbuj funkcję sumowania, aby dodać kilka liczb. Wchodzić:

sum(1, 3, 5) # 9

Używamy funkcji sqrt, aby uzyskać pierwiastek kwadratowy z 16.

sqrt(16) # 4

16^.5 # również daje taką samą odpowiedź jak 4

Pierwiastek kwadratowy jest najczęściej stosowaną transformacją wraz z transformacją logów podczas przygotowywania danych. Wpisz następujące polecenia i sprawdź odpowiedzi

log(1) # 0

log(10) # 2.302585

log10(100) # to zwróci 2, ponieważ log 100 o podstawie 10 wynosi 2. W dowolnym momencie, jeśli chcesz uzyskać dostęp do okna pomocy, możesz wpisać następujące polecenia

help(exp)

? exp

Jeśli chcesz podać przykład funkcji, podaj następujące polecenie:

example (log)

R pozwala zapisać środowisko robocze, w tym zmienne i załadowane biblioteki, do pliku danych .R za pomocą funkcji save.image (). Istniejący plik danych .R można załadować za pomocą funkcji load.image ().

5. Pliki

Polecenia R można zapisywać i przechowywać w plikach tekstowych (z rozszerzeniem ".R") w celu ich późniejszego wykonania. Załóżmy, że zachowaliśmy kilka przykładowych skryptów. Możemy wyświetlić listę plików w bieżącym katalogu z poziomu R wywołując funkcję list.files.

list.files ()

USTAWIANIE KATALOGU ROBOCZEGO

Przed zagłębieniem się w R zawsze lepiej jest skonfigurować katalog roboczy do przechowywania wszystkich naszych plików, skalarów, wektorów, ramek danych itp. Po pierwsze, chcemy wiedzieć, który katalog domyślnie używa R. aby to zrozumieć, wpisz polecenie:

getwd () # [1] "C:/Users/admin/Documents"

Teraz chcę ustawić dane folderu R jako mój katalog roboczy, który znajduje się na dysku D. aby to zrobić, wydam polecenie:

setwd ("D:/ R Data")

Naciśnij Enter (kliknij przycisk Prześlij ikonę), aby upewnić się, że polecenie zostało wykonane i katalog roboczy został ustawiony. Ustawiamy dane folderu R na dysku D jako katalog roboczy. Nie oznacza to, że utworzyliśmy tutaj coś nowego, ale właśnie przypisaliśmy miejsce jako katalog roboczy, tutaj zostaną dodane wszystkie pliki. Aby sprawdzić, czy katalog roboczy został poprawnie skonfigurowany, wydaj polecenie:

getwd ()

STRUKTURY DANYCH W R

Struktura danych to interfejs do danych zorganizowanych w pamięci komputera. R zapewnia kilka rodzajów struktury danych, z których każda ma na celu optymalizację niektórych aspektów przechowywania, dostępu lub przetwarzania. Przykłady struktur danych: 1. Wektor 2. Macierz 3. Czynnik 4. Ramka Danych

1. Wektory

Wektory są podstawowym elementem składowym danych w R. Zmienne R są w rzeczywistości wektorami. Wektor może składać się tylko z wartości z tej samej klasy. Testy wektorów można przeprowadzić za pomocą funkcji is.vector(). Nazwa może brzmieć przerażająco, ale wektor to po prostu lista wartości. Wartościami wektorowymi mogą być liczby, ciągi znaków, wartości logiczne lub dowolny inny typ, o ile wszystkie są tego samego typu. Rodzaje wektorów: Całkowity, Numeryczny, Logiczny, Znakowy, Złożony. R zapewnia funkcjonalność, która umożliwia łatwe tworzenie i manipulowanie wektorami. Poniższy kod R ilustruje sposób tworzenia wektora za pomocą funkcji łączenia, c() lub operatora dwukropka:, Stwórzmy wektor liczb:

c(4,7,9)

Funkcja c (c jest skrótem od Combine) tworzy nowy wektor, łącząc listę wartości. Utwórz wektor z ciągami znaków:

c("a", "b", "c")

Sekwencja wektorów

Możemy stworzyć wektor z notacją początek : koniec, aby utworzyć sekwencje. Zbudujmy wektor z sekwencji liczb całkowitych od 5 do 9.

5:9 # Tworzy wektor o wartościach od 5 do 9

Możemy nawet wywołać funkcję seq. Spróbujmy zrobić to samo z seq:

seq (5,9)

Dostęp do wektora

Po utworzeniu wektora z niektórymi łańcuchami i zapisaniu go, możemy odzyskać indywidualną wartość w wektorze, podając jego indeks liczbowy w nawiasach kwadratowych.

sentence <- c('Learn', 'Data', 'Analytics')

sentence[3] # [1] "Analytics"

Możemy przypisać nowe wartości do istniejącego wektora. Spróbuj zmienić trzecie słowo na "Science":

sentence [3] <- "Science"

Jeśli dodasz nowe wartości do wektora, wektor wzrośnie, aby je uwzględnić. Dodajmy czwarte słowo:

sentence [4] <- 'By YL, Prasad'

Możemy użyć wektora w nawiasach kwadratowych, aby uzyskać dostęp do wielu wartości. Spróbuj uzyskać pierwsze i czwarte słowo:

sentence [c(1, 4)]

Oznacza to, że możesz pobrać zakresy wartości. Uzyskaj od drugiego do czwartego słowa:

sentence [2:4]

Możemy ustawić zakresy wartości, po prostu podając wartości w wektorze.

sentence [5:7] <- c('at', 'PRA', 'Analytix') #aby dodać słowa od 5 do 7

Spróbuj uzyskać dostęp do siódmego słowa wektora sentence:

sentence[7]

Nazwy wektorów

Stwórzmy 3-elementowy wektor i zapiszmy go w zmiennej rang. Możemy przypisywać nazwy do elementów wektora, przekazując drugi wektor wypełniony nazwami do funkcji przypisywania nazw, w następujący sposób:

ranks <- 1:3

names(ranks) <- c("first", "second", "third")

ranks

Możemy użyć tych nazw, aby uzyskać dostęp do wartości wektora.

ranks["first"]

Macierze

Macierz w R to zbiór jednorodnych elementów ułożonych w 2 wymiarach.

• Macierz jest wektorem z atrybutem dim, tj. wektorem liczb całkowitych podającym liczbę lub wiersze i kolumny.

• Funkcje dim(), nrow() i ncol() zapewniają atrybuty macierzy.

• Wiersze i kolumny mogą mieć nazwy, dimnames(), rownames(), colnames()

Przyjrzyjmy się podstawom pracy z macierzami, tworzeniem ich, uzyskiwaniem do nich dostępu i wykreślenia. Stwórzmy macierz o wysokości 3 wierszy i szerokości 4 kolumn, z wszystkimi polami ustawionymi na 0.

Sample <- matrix (0, 3, 4)

Konstrukcja macierzy

Możemy zbudować macierz bezpośrednio z elementami danych, zawartość matrycy jest domyślnie wypełniona wzdłuż orientacji kolumny. Spójrz na poniższy kod, zawartość Sample jest wypełniana kolumnami kolejno.

Sample <- matrix( 1:20, nrow=4, ncol=5)

Dostęp do macierzy

Aby uzyskać wartości z macierzy, wystarczy podać dwa wskaźniki zamiast jednego. Wydrukujmy naszą macierz próbek:

print (Sample)

Spróbuj uzyskać wartość z drugiego wiersza w trzeciej kolumnie Sample:

Sample [2,3]

Możemy uzyskać cały wiersz macierzy, pomijając indeks kolumny (zachowując przecinek). Spróbuj pobrać trzeci rząd:

Sample [3,] # [1] 3 7 11 15

Aby uzyskać całą kolumnę, pomiń indeks wiersza. Pobierz czwartą kolumnę:

Sample [,4] # [1] 13 14 15 16

Czynniki

Gdy chcemy, aby dane zostały pogrupowane według kategorii, R ma specjalny typ zwany factor do śledzenia tych skategoryzowanych wartości. Czynnik jest wektorem, którego elementy mogą przyjmować jedną z określonych wartości. Na przykład "Płeć" zwykle przyjmuje tylko wartości "Mężczyzna", "Kobieta" i "NA". Zbiór wartości, które mogą przyjmować elementy czynnika, nazywa się jego poziomami.

Tworzenie Czynników

Aby kategoryzować wartości, wystarczy przekazać wektor do funkcji factor:

gender <- c('male', 'female', 'male', 'NA', 'female')

types <- factor(gender)

print(gender)

Zobaczysz nieprzetworzoną listę ciągów, powtarzane wartości i inne. Teraz wyświetl współczynnik typów:

print(types)

Rzućmy okiem na leżące u podstaw liczby całkowite. Przekaż współczynnik do funkcji as.integer:

as.integer(types) # [1] 2 1 2 3 1

Za pomocą funkcji poziomów można uzyskać tylko poziomy czynników:

levels(types) # [1] "female" "male" "NA"

Ramki danych

Ramki danych zapewniają strukturę do przechowywania i uzyskiwania dostępu do kilku zmiennych możliwie różnych typów danych. Ze względu na ich elastyczność w obsłudze wielu typów danych, ramki danych są preferowanym formatem wejściowym dla wielu funkcji modelowania dostępnych w R. Utwórzmy trzy indywidualne obiekty o nazwach Id, Gender i Age i połączmy je w zbiór danych.

Id <- c(101, 102, 103, 104, 105)

Gender <- c('male', 'female', 'male', 'NA', 'female')

Age <- c(38,29,NA,46,53)

Id, Gender i Age są trzema pojedynczymi obiektami, R ma strukturę znaną jako ramka danych, która może powiązać wszystkie te zmienne w jednej tabeli lub arkuszu kalkulacyjnym Excel. Ma określoną liczbę kolumn, z których każda powinna zawierać wartości określonego typu. Ma także nieokreśloną liczbę wierszy - zestawy powiązanych wartości dla każdej kolumny. Łatwo jest utworzyć zestaw danych, wystarczy wywołać funkcję data.frame i podać argumenty Id, Gender i Age. Przypisz wynik do zestawu danych Test:

Test <- data.frame(Id, Gender, Age)

Wyświetl test, aby zobaczyć jego zawartość:

print(Test)

fix(Test) # Aby wyświetlić ten zestaw danych obiektu

Dostęp do ramki danych: Dostęp do poszczególnych części ramki danych jest łatwy. Możemy uzyskać poszczególne kolumny, podając ich numer indeksu w nawiasach podwójnych. Spróbuj uzyskać drugą kolumnę (Gender) Test:

Test [[2]]

Możesz podać nazwę kolumny jako ciąg w nawiasach podwójnych dla większej czytelności

Test [["Age"]]

Możemy nawet użyć skrótu: nazwa ramki danych, znak dolara i nazwa kolumny bez cudzysłowów.

Test$Gender

2.5 IMPORTOWANIE I EKSPORTOWANIE DANYCH

Dość często musimy pozyskiwać nasze dane z zewnętrznych plików, takich jak pliki tekstowe, arkusze Excela i pliki CSV, aby wykonać to R otrzymał możliwość łatwego ładowania danych z zewnętrznych plików. Twoje środowisko może mieć wiele obiektów i wartości, które możesz usunąć za pomocą następującego kodu:

rm(list = ls ())

Funkcja rm() umożliwia usuwanie obiektów z określonego środowiska. Importowanie plików TXT: Jeśli masz plik .txt lub plik tekstowy rozdzielany tabulatorami, możesz go łatwo zaimportować za pomocą podstawowej funkcji R read.table ().

setwd ("D: / R Data")

Inc_ds <- read.table ("Income.txt")

W przypadku plików, które używają ciągów separatora innych niż przecinki, można użyć funkcji read.table. Argument sep = definiuje znak separatora i można określić znak tabulacji za pomocą "\t". Wywołaj read.table na "Inc_tab.txt", używając separatorów tabulatorów:

read.table ("Inc_tab.txt", sep= "\t")

Czy zauważysz nagłówki kolumn "V1", "V2" i "V3"? Pierwszy wiersz nie jest automatycznie traktowany jako nagłówki kolumn w read.table. To zachowanie jest kontrolowane przez argument nagłówka. Ponownie wywołaj read.table, ustawiając nagłówek na TRUE:

Inc_th <- read.table ("Inc_tab.txt", sep= "\ t", nagłówek = TRUE)

fix (Inc_th)

Importowanie plików CSV: Jeśli masz plik, który oddziela wartości przecinkiem, zwykle masz do czynienia z plikiem .csv. Możesz załadować zawartość pliku CSV do ramki danych, przekazując nazwę pliku do funkcji read.CSV.

read.CSV ("Employee.csv") # Wykonanie tego R oczekuje obecności naszych plików w katalogu roboczym.

Eksporujemy pliki za pomocą funkcji write.table: Funkcja write.table generuje pliki danych. Pierwszy argument określa, która ramka danych w R ma zostać wyeksportowana. Następny argument określa plik do utworzenia. Domyślny separator to pusta spacja, ale dowolny separator można określić w opcji sep =. Ponieważ nie chcemy dołączać nazw wierszy, otrzymaliśmy opcję row.names = FALSE, Domyślnym ustawieniem opcji quote jest uwzględnianie cudzysłowów wokół wszystkich wartości znaków, tj. Wokół wartości w zmiennych łańcuchowych i wokół nazw kolumn. Jak pokazaliśmy w tym przykładzie, bardzo często nie chce się cytatów podczas tworzenia pliku tekstowego.

write.table(Employee, file="emp.txt", row.names = FALSE, quote = FALSE)

KROK 3

Eksploracja Danych

WPROWADZENIE

Ilekroć mamy zamiar stworzyć model, bardzo ważne jest, aby zrozumieć dane i znaleźć ukryty wgląd w dane. Powodzenie projektu analizy danych wymaga głębokiego zrozumienia danych. Eksploracja danych pomoże ci stworzyć dokładne modele, jeśli wykonasz to w zaplanowany sposób. Przed formalną analizą danych analityk musi wiedzieć, ile przypadków znajduje się w zbiorze danych, jakie zmienne są uwzględnione, ile brakujących obserwacji znajduje się w zbiorze danych. Etapy eksploracji danych obejmują zrozumienie zbiorów danych i zmiennych, sprawdzanie atrybutów danych, rozpoznawanie i usuwanie brakujących wartości, wartości odstających, zrozumienie podstawowej prezentacji danych itp. działania w zakresie eksploracji danych obejmują badanie danych w zakresie podstawowych miar statystycznych i tworzenie wykresy i wykresy do wizualizacji i identyfikacji relacji i wzorców. Wstępna eksploracja zestawu danych pomaga odpowiedzieć na te pytania, zapoznając analityków z danymi, z którymi pracują. Dodatkowe pytania i uwagi dotyczące etapu warunkowania danych obejmują: Jakie są źródła danych? Jakie są pola docelowe? Jak czyste są dane? Jak spójna jest zawartość i pliki? Jako specjalista ds. danych musisz ustalić, w jakim stopniu dane zawierają brakujące lub niespójne wartości oraz czy dane zawierają wartości odbiegające od normalnych, i oceń spójność typów danych. Na przykład, jeśli zespół spodziewa się, że pewne dane będą liczbowe, potwierdź, że są one numeryczne lub jest to połączenie ciągów alfanumerycznych i tekstu. Przejrzyj zawartość kolumn danych lub innych danych wejściowych i sprawdź, czy mają one sens. Na przykład, jeśli projekt obejmuje analizę poziomów dochodów, wyświetl podgląd danych, aby potwierdzić, że wartości dochodów są dodatnie lub czy dopuszczalne są zera lub wartości ujemne. Poszukaj dowodów na systematyczny błąd. Przykłady obejmują przesyłanie danych z czujników lub innych źródeł danych, które ulegają awarii bez uprzedzenia, co powoduje nieprawidłowe, nieprawidłowe lub brakujące wartości danych. Przejrzyj dane do pomiaru, jeśli definicja danych jest taka sama dla wszystkich pomiarów. W niektórych przypadkach kolumna danych jest zmieniana lub kolumna przestaje być zapełniana, bez opisywania tej zmiany lub powiadamiania innych. Po zebraniu przez zespół przynajmniej niektórych zestawów danych potrzebnych do późniejszej analizy, przydatnym krokiem jest wykorzystanie narzędzi do wizualizacji danych w celu przeanalizowania wzorców wysokiego poziomu w danych, umożliwiając bardzo szybkie zrozumienie cech danych. Jednym z przykładów jest użycie wizualizacji danych w celu zbadania jakości danych, takich jak to, czy dane zawierają wiele nieoczekiwanych wartości lub innych wskaźników brudnych danych. Innym przykładem jest Skośność, jeśli większość danych jest mocno przesunięta w kierunku jednej wartości lub końca kontinuum. Wizualizacja danych umożliwia użytkownikowi wyszukiwanie interesujących obszarów, powiększanie i filtrowanie w celu znalezienia bardziej szczegółowych informacji o danym obszarze danych, a następnie wyszukanie szczegółowych danych w określonym obszarze. Takie podejście zapewnia ogólny widok danych i dużą ilość informacji o danym zbiorze danych w stosunkowo krótkim czasie.

WYTYCZNE I UWAGI

Przejrzyj dane, aby upewnić się, że obliczenia pozostały spójne w kolumnach lub tabelach dla danego pola danych. Na przykład, czy czas życia klienta zmienił się w pewnym momencie w trakcie gromadzenia danych? Lub jeśli pracujesz z finansami, czy obliczanie odsetek zmieniło się z prostych na złożone na koniec roku? Czy dystrybucja danych pozostaje spójna we wszystkich danych? Jeśli nie, jakie działania należy podjąć, aby rozwiązać ten problem? Oceń ziarnistość danych, zakres wartości i poziom agregacji danych. Czy dane reprezentują populację będącą przedmiotem zainteresowania? W przypadku danych marketingowych, jeśli projekt koncentruje się na klientach w wieku wychowawczym, czy dane te reprezentują to, czy są pełne seniorów i nastolatków? Czy w przypadku zmiennych związanych z czasem pomiary są codzienne, tygodniowe, miesięczne? Czy to wystarczy? Czy wszędzie mierzy się czas w sekundach? A może w niektórych miejscach są to milisekundy? Określ poziom szczegółowości danych potrzebnych do analizy i oceń, czy obecny poziom znaczników czasu w danych spełnia tę potrzebę. Czy dane są standaryzowane / znormalizowane? Czy skale są spójne? Jeśli nie, w jakim stopniu dane są spójne lub nieregularne? Są to typowe kwestie, które powinny być częścią procesu myślowego, gdy zespół ocenia zestawy danych uzyskane dla projektu. Zdobycie głębokiej wiedzy na temat danych będzie miało kluczowe znaczenie, gdy przyjdzie czas na budowę i uruchamianie modeli w dalszej części procesu.

SPRAWDŹ CZĘŚĆ DANYCH DATASET

setwd("D:/R data")

Employee <- read.csv("Employee.csv")

fix(Employee)

print(Employee)

Funkcja print() wyświetla zawartość ramki danych (lub dowolnego innego obiektu). Zawartość można zmienić za pomocą funkcji edit().

edit(Employee)

SPRAWDŹ WYMIAR DANYCH

Użyj dim(), aby uzyskać wymiary ramki danych (liczba wierszy i liczba kolumn). Dane wyjściowe to wektor.

Dim(Employee)

Użyj nrow() i ncol(), aby uzyskać odpowiednio liczbę wierszy i liczbę kolumn. Możemy uzyskać te same informacje, wyodrębniając pierwszy i drugi element wektora wyjściowego z dim().

nrow(Employee)

ncol(Employee)

Sprawdź funkcje i zrozum dane, wyświetlając kilka pierwszych wierszy za pomocą funkcji head(). Domyślnie R wyświetli pierwsze 6 wierszy. Możemy użyć head(), aby uzyskać pierwsze n obserwacji, a tail(), aby uzyskać ostatnie n obserwacji; domyślnie n = 6. Są to dobre polecenia do uzyskania intuicyjnego wyobrażenia o tym, jak wyglądają dane, bez ujawniania całego zestawu danych, który może mieć miliony wierszy i tysiące kolumn.

head(Employee)

Jeśli chcemy wybrać tylko kilka wierszy, możemy określić tę liczbę wierszy.

Selecting Rows(Observations)

Samp <- Employee[1:3,]

head(mydata) # Pierwsze 6 wierszy zestawu danych

head(mydata, n=10) # Pierwsze 10 wierszy zestawu danych

head(mydata, n= -10) # Wszystkie wiersze oprócz ostatnich 10

tail(mydata) # Ostatnie 6 wierszy

tail(mydata, n=10) # Ostatnie 10 wierszy

tail(mydata, n= -10) # Wszystkie wiersze oprócz pierwszych 10

Nazwy zmiennych lub nazwy kolumn

names(Employee)

SPRAWDŹ CZĘŚĆ OPISU DATASETU

Część deskryptora oznacza metadane (dane o danych):

str(Employee)

Funkcja str() zapewnia strukturę ramki danych. Ta funkcja identyfikuje całkowite i liczbowe (podwójne) typy danych, zmienne czynnikowe i poziomy, a także kilka pierwszych wartości dla każdej zmiennej. Wykonując powyższy kod, możemy uzyskać informacje o atrybutach zmiennych, takich jak nazwa zmiennej, typ itp. "Num" oznacza, że zmienna "count" jest liczbowa (ciągła), a "Factor" oznacza, że zmienna jest kategoryczna z kategoriami lub poziomami. Polecenie sapply (Employee, class) zwróci nazwy i klasy (np. numeryczne, liczby całkowite lub znaki) każdej zmiennej w ramce danych.

sapply(Employee, class)

Aby uzyskać wszystkie kategorie lub poziomy zmiennej jakościowej, użyj funkcji levels()

levels(Employee)

TWORZENIE WIZUALIZACJI

Powszechnie używamy wizualizacji danych do eksploracji danych, ponieważ pozwala ona użytkownikom na szybkie i proste przeglądanie większości istotnych funkcji zestawu danych. Wizualizacje pomagają nam zidentyfikować zmienne, które mogą mieć interesujące relacje. Wyświetlając dane graficznie za pomocą wykresów punktowych lub wykresów słupkowych, możemy sprawdzić, czy dwie lub więcej zmiennych koreluje i ustalić, czy są dobrymi kandydatami do dalszej szczegółowej analizy. Przydatnym sposobem postrzegania wzorców i niespójności w danych jest eksploracyjna analiza danych z wizualizacją. Wizualizacja daje zwięzły obraz danych, które mogą być trudne do zrozumienia na podstawie samych liczb i podsumowań. Zmienne x i y danych w ramce danych można zamiast tego wizualizować na wykresie, który łatwo przedstawia związek między dwiema zmiennymi. Wizualizacja pomaga nam tworzyć różne typy wykresów, takie jak:

1. Histogram

2. Wykres kołowy

3. Wykres słupkowy / liniowy

4. Fabuła pudełka

5. Wykres punktowy

Histogramy: Histogramy można tworzyć za pomocą funkcji hist(x), gdzie x jest wektorem liczbowym wartości do wykreślenia. Opcja freq = FALSE wykreśla gęstości prawdopodobieństwa zamiast częstotliwości. Opcja breaks = kontroluje liczbę pojemników.

# Prosty histogram

hist(Employee$Salary)

# Kolorowy histogram z różną liczbą pojemników

hist(Employee$Salary, breaks=12, col="red")

# Nałożone histogramy

hist(Employee$Salary, breaks="FD", col="green")

hist(Employee$Salary [Employee$Gender=="Male"], breaks="FD", col="gray",

add=TRUE)

legend("topright", c("Female","Male"), fill=c("green","gray"))

Wykresy kołowe: Wykresy kołowe są tworzone za pomocą funkcji pie(x, labels =), gdzie x jest nieujemnym wektorem numerycznym wskazującym obszar każdego wycinka, a labels = zapisuje wektor znakowy nazw dla wycinków.

# Prosty wykres kołowy

Items_sold <- c(10, 12,4, 16, 8)

Location <- c("Hyderabad", "Bangalore", "Kolkata", "Mumbai", "Delhi")

pie(Items_sold, labels = Location, main="Pie Chart of Locations")

# 3D Rozłożony wykres kołowy

library(plotrix)

pie3D(slices,labels=lbls,explode=0.1, main="Pie Chart of Countries ")

Wykres słupkowy / liniowy:

Wykres liniowy: Wykresy liniowe są zwykle preferowane, gdy mamy analizować rozkład trendów w danym okresie. Wykres liniowy nadaje się również do wykresów, w których musimy porównać względne zmiany wielkości w pewnej zmiennej (jak czas).

# Aby utworzyć prosty wykres liniowy:

Plot(, type=l)

Wykresy pudełkowe: Wykresy pudełkowe można tworzyć dla poszczególnych zmiennych lub dla zmiennych według grup. Format to boxplot(x, data =), gdzie x jest formułą, a data = oznacza ramkę danych dostarczającą dane. Przykładem formuły jest grupa y~, w której dla każdej wartości grupy generowany jest osobny wykres pudełkowy dla zmiennej numerycznej y. Dodaj varwidth = TRUE, aby szerokości wykresu pudełkowego były proporcjonalne do pierwiastka kwadratowego z rozmiarów próbek. Addhorizontal = TRUE, aby odwrócić orientację osi.

# Boxplot wynagrodzenia według wykształcenia

boxplot(Salary~Education,data=Employee, main="Wynagrodzenia według wykształcenia", xlab="Education", ylab="Salary")

boxplot jest słowem kluczowym do generowania boxplot. Wykres odbywa się między wynagrodzeniem pracowników a poziomem wykształcenia. Istnienie wartości odstających w zbiorze danych obserwuje się jako punkty poza ramką.

Wykresy rozrzutu: Istnieje wiele sposobów tworzenia wykresu rozrzutu w R. Podstawową funkcją jest plot(x, y), gdzie x i y to wektory numeryczne oznaczające punkty (x, y) do wykreślenia.

# Prosty wykres rozrzutu

attach(Employee)

plot(Age, Salary, main="Scatterplot on Age vs Salary",

xlab="Age", ylab="Salary ", pch= 19

BRAK DANYCH

Przyjrzyjmy się, jak można wykryć brakujące dane w fazie eksploracji danych za pomocą wizualizacji. Ogólnie rzecz biorąc, analitycy powinni szukać anomalii, weryfikować dane ze znajomością domeny i decydować o najbardziej odpowiednim podejściu do czyszczenia danych. Rozważ scenariusz, w którym bank przeprowadza analizy danych posiadaczy rachunków w celu oceny zatrzymania klientów.

rowSums(is.na(mydata)) # Liczba braków w wierszu

colSums(is.na(mydata)) # Liczba braków w kolumnie / zmiennej

# Konwertuj na brakujące dane

mydata[mydata$age=="& ","age"] <- NA

mydata[mydata$age==999,"age"] <- NA

# Funkcja complete.cases() zwraca logiczny wektor wskazujący, które przypadki są zakończone

# lista wierszy danych, w których brakuje wartości

mydata[!complete.cases(mydata),]

# Funkcja na.omit () zwraca obiekt z listowym usunięciem brakujących wartości.

# Tworzenie nowego zestawu danych bez brakujących danych

mydata1 <- na.omit(mydata)

Wartości ekstremalne: obserwacje ekstremalne są przedmiotem zainteresowania i zasługują na naszą uwagę, ponieważ są czymś więcej niż zwykłymi wartościami odstającymi na końcu krzywej dzwonowej. Są to te, które wypaczają rozkład do pokazanego wcześniej kształtu F. Wykres pola dla wykrywania wartości odstających: wartość odstająca jest wynikiem bardzo różnym od reszty danych. Analizując dane, musimy pamiętać o takich wartościach, ponieważ wpływają one na model, który pasujemy do danych. Dobry przykład tego uprzedzenia można zobaczyć, patrząc na prosty model statystyczny, taki jak średnia. Załóżmy, że film otrzymuje ocenę od 1 do 5. Siedem osób obejrzało film i oceniło film z ocenami 2, 5, 4, 5, 5, 5 i 5. Wszystkie z wyjątkiem jednej z tych ocen są dość podobne (głównie 5 i 4), ale pierwsza ocena była zupełnie inna od pozostałych. To była ocena 2. To jest przykład wartości odstającej. Wykresy pudełkowe mówią nam coś o rozkładach wyników. Wykresy pokazują nam najniższą (dolną poziomą linię) i najwyższą (górną) linię poziomą. Odległość między najniższą poziomą linią a najniższą krawędzią przyciemnionego pudełka to zakres, między którym przypada najniższe 25% wyników (tzw. dolny kwartyl). Ramka (zabarwiony obszar) pokazuje środkowe 50% wyników (znane jako zakres międzykwartylowy); tj. 50% wyników jest większych niż najniższa część zabarwionego obszaru, ale mniejsza niż górna część zabarwionego obszaru. Odległość między górną krawędzią przyciemnionego pudełka a górną poziomą linią pokazuje zakres, pomiędzy którym przypada górne 25% wyników (górny kwartyl). Na środku przyciemnionego pudełka znajduje się nieco grubsza pozioma linia. To reprezentuje wartość mediany. Podobnie jak histogramy, mówią nam również, czy rozkład jest symetryczny czy pochylony. W celu symetrycznego rozmieszczenia wąsów po obu stronach pudełka mają one równą długość. Wreszcie zauważysz małe kółka nad każdym polem wykresu. Są to przypadki uważane za wartości odstające. Każde koło ma obok siebie liczbę, która mówi nam, w którym rzędzie edytora danych znaleźć przypadek. Wykres ramkowy jest szeroko stosowany do badania istnienia wartości odstających w zbiorze danych. Dwa ważne fakty, o których należy pamiętać w przypadku wykresu pudełkowego to : 1. Liczba obserwacji w zestawie danych musi wynosić co najmniej pięć. 2. Jeśli w zestawie danych znajduje się więcej niż jedna kategoria, należy je posortować według kategorii. Zestaw danych zawierający oceny 5 studentów z przedmiotów z języka angielskiego i przedmiotów ścisłych istnieje w formacie CSV. boxplot jest słowem kluczowym do generowania boxplot. Wykreślanie odbywa się między ocenami uzyskanymi przez studentów a przedmiotem. Istnienie wartości odstających w zbiorze danych obserwuje się jako punkty poza ramką. Chcemy skupić się na interesujących momentach na peryferiach, znanych jako wartości odstające i dlaczego mogą być ważne. Kiedy wartości odstające stają się skrajnymi obserwacjami po lewej lub po prawej stronie, może to zmienić założenia przyjęte przez statystę w konfiguracji badania dotyczące zachowania rekrutowanej populacji, co może zagrozić dowodowi badania i ostatecznie kosztownej porażce. Obserwacje ekstremalne są przedmiotem zainteresowania i zasługują na naszą uwagę, ponieważ są czymś więcej niż zwykłymi wartościami odstającymi na końcu krzywej dzwonowej. Są to te, które wypaczają rozkład do kształtu F.

KROK 4

Przygotowanie Danych

WPROWADZENIE

Przygotowanie danych obejmuje etapy eksploracji, przetwarzania wstępnego i danych reklamacyjnych przed modelowaniem i analizą. Szczegółowe zrozumienie danych ma kluczowe znaczenie dla powodzenia projektu. Musimy zdecydować, w jaki sposób uwarunkować i przekształcić dane, aby uzyskać format umożliwiający późniejszą analizę. Może być konieczne wykonanie wizualizacji danych, aby pomóc nam zrozumieć dane, w tym ich trendy, wartości odstające i relacje między zmiennymi danych. Przygotowanie danych jest zwykle najbardziej pracochłonnym krokiem i w rzeczywistości zespoły spędzają co najmniej 50% czasu projektu w tej krytycznej fazie. Jeśli zespół nie jest w stanie uzyskać wystarczającej ilości danych o wystarczającej jakości, może nie być w stanie wykonać kolejnych kroków w cyklu życia. Przygotowanie danych odnosi się do procesu czyszczenia danych, normalizacji zestawów danych i wykonywania transformacji danych. Krytyczny krok w cyklu życia analizy danych, warunkowanie danych może obejmować wiele skomplikowanych kroków w celu połączenia lub scalenia zestawów danych lub w inny sposób wprowadzenia zestawów danych w stan umożliwiający analizę w kolejnych fazach. Uwarunkowanie danych jest często postrzegane jako etap przetwarzania wstępnego dla analizy danych, ponieważ obejmuje wiele operacji na zbiorze danych przed opracowaniem modeli do przetwarzania lub analizy danych. Etapy przygotowania danych obejmują:

1. Tworzenie nowych zmiennych.

2. Grupowanie danych, usuwanie duplikatów obserwacji w zbiorze danych.

3. Formatowanie.

4. Przechowywanie, upuszczanie, zmiana nazwy, etykietowanie.

5. Przetwarzanie warunkowe.

6. Funkcje.

7. Łączenie zestawów danych.

8. Transpozycja danych.

TWORZENIE NOWYCH ZMIENNYCH

Weźmy zestaw danych pracowników, mamy ich miesięczne dane dotyczące dochodu, chcemy obliczyć podwyżkę ich wynagrodzeń i obliczyć nową pensję. Używamy operatora przypisania (<-) do tworzenia nowych zmiennych.

setwd("D:/R data")

Employee <- read.csv("Employee.csv")

fix(Employee)

Utwórz zmienną o nazwie Bonus z 8% wzrostem wynagrodzenia

Employee$Bonus <- Employee$Salary*.08

Employee$Newsal <- Employee$Salary + Employee$Bonus

fix(Employee)

SORTOWANIE DANYCH

Aby zgrupować ramkę danych w R, użyj funkcji order(). Domyślnie sortowanie jest ROSNĄCE. Dodaj zmienną sortującą. Znak minus oznacza kolejność MALEJĄCO.

# Sortuj według wieku

Agesort <- Employee[order(Age),]

#Sortowanie z wieloma zmiennymi, sortuj według płci i wieku

Mul_sort <- Employee[order(Gender, Age),]

Wykonując powyższy kod, posortowaliśmy ramkę danych na podstawie Gender jako pierwszej preferencji i Age jako drugiej.

#Sortuj według Gender (rosnąco) i Age (malejąco)

Rev_sort <- Employee[order(Gender, -Age),]

detach(Employee)

IDENTYFIKACJA I USUWANIE DUPLIKOWANYCH DANYCH

Możemy usunąć zduplikowane dane za pomocą funkcji duplicated() i unique(), a także funkcji odrębnej w pakiecie dplyr. Funkcja duplicated() zwraca wektor logiczny, w którym PRAWDA określa, które elementy wektora lub ramki danych są duplikatami. Biorąc pod uwagę następujący wektor:

Cust_Id <- c (101, 104, 104, 105, 104, 105)

Aby znaleźć pozycję zduplikowanych elementów w x, możemy użyć tego:

duplicated(Cust_Id)

Możemy wyświetlić zduplikowane elementy, wykonując następujący kod.

Cust_Id [duplicated(Cust_Id)]

Jeśli chcesz usunąć zduplikowane elementy i uzyskać tylko unikalne wartości, użyj! Duplicated(), gdzie! jest logiczną negacją:

Uniq_Cust <- Cust_Id [! Duplicated (Cust_Id)]

W naszych codziennych zadaniach musimy tworzyć, modyfikować, manipulować i przekształcać dane, aby przygotować je do analizy i raportowania. Używamy niektórych lub innych funkcji do większości operacji na danych. Znajomość tych funkcji może znacznie ułatwić programowanie. Możemy usunąć zduplikowane wiersze z ramki danych na podstawie wartości kolumn, w następujący sposób: # Usuń duplikaty na podstawie kolumn Work_Balance

Uniq_WB <- Employee [!duplicated(Employee$ Work_Balance), ]

Możesz wyodrębnić unikalne elementy w następujący sposób:

unique(Cust_Id)

Możliwe jest również zastosowanie unique() do ramki danych, aby usunąć zduplikowane wiersze w następujący sposób:

unique(Employee)

Funkcja distinct() w pakiecie dplyr może być używana do przechowywania tylko unikatowych / odrębnych wierszy z ramki danych. Jeśli istnieją zduplikowane wiersze, zachowany zostanie tylko pierwszy wiersz. Jest to wydajna wersja podstawowej funkcji R unique(). Pakiet dplyr można załadować i zainstalować w następujący sposób:

install.packages("dplyr")

library("dplyr")

Usuń zduplikowane wiersze na podstawie wszystkich kolumn:

distinct(Employee)

#Usuń zduplikowane wiersze na podstawie określonych kolumn (zmiennych): Usuń zduplikowane wiersze na podstawie JobSatisfaction.

distinct(Employee, JobSatisfaction)

# Usuń zduplikowane wiersze na podstawie JobSatisfaction i Perf_Rating.

distinct(Employee, JobSatisfaction, Perf_Rating)

FILTROWANIE OBSERWACJI NA PODSTAWIE WARUNKÓW

Age_Con <- Employee[which(Employee$Age < 40), ]

Podczas filtrowania obserwacji na podstawie zmiennych znakowych musimy osadzić ciąg w cudzysłowach.

Sex_Con <- Employee[which(Employee$Gender ="male"), ]

Filtruj obserwacje na podstawie wielu warunków

Mul_Con <-Employee[which(Employee $Gender=='Female' & Employee $Age < 30),]

Wybór za pomocą funkcji subset

Funkcja subset() jest najłatwiejszym sposobem wybierania zmiennych i obserwacji. W poniższym przykładzie wybieramy wszystkie wiersze, które mają wartość wieku większą lub równą 50 lub wiek mniejszą niż 30. Zachowujemy kolumny Emp_Id i Age.

# Korzystanie z funkcji podzbioru

Test <- subset(Employee, Age >= 50 | Age < 30, select=c(Emp_Id, Age))

Przetwarzanie warunkowe

Dość często musimy przetwarzać dane w oparciu o określone warunki, a podejmowanie decyzji jest ważną częścią programowania. Można to osiągnąć za pomocą warunkowej instrukcji if ... else.

Składnia instrukcji If:

if (test_expression) {

statement

}

Możemy tworzyć nowe zmienne, używając, jeśli inaczej. Chcemy promować nasz produkt tylko wśród osób, których dochód przekracza 40 tys.

Employee$Promo <- ifelse(Employee$Salary>40000,"Promote Product","Do not Promote Product")

fix(Employee)

# Tutaj sprawdzamy, czy elementy Wynagrodzenia pracownika $ są większe niż 40000, jeśli element jest większy niż 40000, przypisuje wartość Promuj produkt do promocji pracownika, a jeśli nie jest on większy niż 40000, przypisuje wartość z Nie promuj produktu na promocję $ pracownik. Chcemy przypisać wartości Low, Medium i High do zmiennej Sal_Grp. Aby to zrobić, możemy użyć zagnieżdżonych instrukcji ifelse():

Employee$Sal_Grp <-ifelse(Employee$Salary >20000 & Employee$Salary<50000," Medium",

ifelse(Employee$Salary >= 50000, "High","Low"))

Teraz to mówi, najpierw sprawdź, czy każdy element wektora Salary jest > 20000 i < 50000. Jeśli tak, przypisz Medium do Sal_Grp. Jeśli tak nie jest, sprawdź następną instrukcję ifelse (), czy Salary > 50000. Jeśli tak, przypisz Sal_Grp wartość High. Jeśli nie jest to żaden z nich, przypisz Low.

FORMATOWANIE

Jest to powszechnie stosowane w celu poprawy wyglądu danych wyjściowych, możemy używać już istniejących (zdefiniowanych przez system) formatów, a nawet tworzyć niestandardowe formaty do wartości bin w efektywny sposób. Korzystając z tego, możemy grupować dane na różne sposoby, bez konieczności tworzenia nowego zestawu danych. Wyobraźmy sobie, przeprowadziliśmy ankietę na temat nowego produktu (A / c): Ogólnie zadowolony - 1 - Bardzo niski 2 - Niski 3. OK, 4 - Dobry 5 Bardzo dobry. Chociaż istnieje wiele sposobów pisania niestandardowych rozwiązań, analityk powinien znać specjalne procedury, które mogą zmniejszyć potrzebę niestandardowego kodowania. R będzie traktować czynniki jako zmienne nominalne, a czynniki uporządkowane jako zmienne porządkowe. Możesz użyć opcji w funkcjach factor() i ordered() do sterowania mapowaniem liczb całkowitych na ciągi. Możemy użyć funkcji czynnikowej do stworzenia własnych etykiet wartości.

setwd("D:/R data")

Shop <- read.csv("Shopping.csv")

fix(Shop)

# Zmienna marki w zestawie danych Sklepu ma kod 1, 2, 3 .: Chcemy dołączyć etykiety wartości

1=Samsung, 2=Hitachi, 3=Bluestar.

Shop$Brand <- factor(Shop$Brand, levels = c(1,2,3),

labels = c("Samsung", "Hitachi", "Bluestar"))

# zmienna y jest kodowana 1,2, 3,4 i 5 # chcemy dołączyć etykiety wartości 1 - Bardzo niski 2 - Niski 3. OK 4 - Ddobry 5 - Bardzo dobry.

Shop$Overall_Sat <- ordered(Shop$Overall_Sat, levels = c(1,2,3,4,5),

labels = c("Very Low", "Low", "OK", "Good", "Extremely Good"))

Czasami możesz chcieć utworzyć nową zmienną kategorialną, klasyfikując obserwacje według wartości zmiennej ciągłej. Załóżmy, że chcesz utworzyć nową zmienną o nazwie Age.Cat, która klasyfikuje ludzi jako "Młodych", "Dorosłych" i "Starych" według ich wieku. Osoby w wieku poniżej 35 lat są klasyfikowane jako młode, osoby między 35 a 60 rokiem życia są klasyfikowane jako dorośli, a osoby powyżej 60 lat są klasyfikowane jako osoby starsze.

Employee$Age.Cat<-cut(Employee$Age, c(18,35, 60,90), c("Young", "Adult", "Old")

UTRZYMANIE, OPADANIE, ZMIANA NAZWY, ETYKIETOWANIE

# Wybierz zmienne

myvars <- c("Brand", "Safety", "Look")

Sub_shop <- Shop[myvars]

fix(Sub_shop)

# Wyklucz 4 i 6 zmienną

Sub_data <- Shop[c(-4,-6)]

fix(Sub_data)

# Zmień nazwę interaktywnie

fix(Shop) # results are saved on close

# Zmień nazwę programowo

library(reshape)

Ren_Shop <- rename(Shop, c(Safety="Security"))

Etykietowanie zmiennych: Możemy przypisać etykiety zmiennych w var.labels do kolumn w danych ramki danych za pomocą etykiety funkcji z pakietu Hmisc.

install.packages("Hmisc")

library("Hmisc")

label(Shop[["Overall_Sat"]]) <- "Overall Satisfaction of the Customer"

label(Shop[["Look"]]) <- "Look and Feel of the Product"

label(Shop)

FUNKCJE

Funkcja zwraca wartość z obliczeń lub manipulacji systemem, która wymaga zero lub więcej argumentów. Funkcja jest tworzona przy użyciu słowa kluczowego function. Podstawowa składnia definicji funkcji R jest następująca:

New_Var <- nazwa_funkcji (Argument1, Argument2, ... N).

Funkcja jest rozpoznawana przez użycie nazwy funkcji, po której następuje natychmiast argument (argumenty) funkcji, oddzielone przecinkami i ujęte w nawiasy. Liczba wymaganych i opcjonalnych argumentów jest jednak różna. Niektóre funkcje mają po prostu jeden wymagany argument. Inne mają jeden wymagany i jeden lub więcej opcjonalnych argumentów. W większości przypadków ważna jest kolejność argumentów. Niektóre funkcje nie przyjmują argumentów, w takim przypadku wymagany jest zerowy zestaw nawiasów.

Funkcje znakowe

Funkcje toupper, tolower: Te funkcje zmieniają wielkość liter argumentu

Name <- 'Ramya Kalidindi' #Przypisywanie wartości do zmiennej

upcf <- toupper (Name)

locf <- tolower(Name)

Funkcja trimws: Dość często dane, które otrzymujemy, mogą zawierać niepożądane spacje i chcemy je usunąć, aby nasze dane były czyste. Używamy funkcji trimws, aby radzić sobie z odstępami łańcucha.

Name <- " Y Lakshmi Prasad "

Trimmed_Name <- trimws(Name, which = c("both", "left", "right"))

Funkcja substr: Ta funkcja służy do wydobywania znaków ze zmiennych łańcuchowych. Argumenty substr() określają wektor wejściowy, początkową pozycję znaku i końcową pozycję znaku. Ostatni parametr jest opcjonalny. W przypadku pominięcia wszystkie znaki po lokalizacji określonej w drugim miejscu zostaną wyodrębnione.

Req_Name <- substr(Name, 6, 12)

Tworzenie zmiennej łańcuchowej ze zmiennych numerycznych

stringx <- as.character (numericx)

typeof (stringx)

typeof (numericx)

Funkcja typeof() może być używana do weryfikacji typu obiektu, możliwe wartości to logiczne, całkowite, podwójne, złożone, znakowe, surowe, lista, NULL, zamknięcie (funkcja), specjalne i wbudowane.

Twórz zmienne numeryczne ze zmiennych łańcuchowych.

Argument w funkcji as.numeric, liczba całkowita jest liczbą znaków w łańcuchu, podczas gdy liczba dziesiętna jest opcjonalną specyfikacją, ile znaków występuje po przecinku.

numericx <- as.numeric (stringx)

typeof (stringx)

typeof (numericx)

Zadanie: Oblicz przyrost na 10% i uzyskaj nowe wynagrodzenie dla każdego Id.

Num_data <- data.frame(Id = c(101,102,103),

Salary =c(40700,12000,37000))

sapply(Num_data, mode)

Num_data$Char_sal <- as.character(Num_data$Salary)

typeof(Num_data$Char_sal)

Num_data$Saln <- as.numeric(Num_data$Char_sal)

typeof(Num_data$Saln)

Num_data$Bonus <- Num_data$Saln*.10

fix(Num_data)

Num_data$New_Sal <- Num_data$Saln+Num_data$Bonus

Funkcje numeryczne

Funkcja Abs: Używamy tej funkcji do uzyskania wartości bezwzględnej;

a = 5

aba <- abs (a)

Val <- -28,86

Req <- abs (Val))

Wartości Floor(Base) and ceiling(Top):

Flx = floor(X) # Wartość bazowa

Cilx = ceilling(X) # Najwyższa wartość

Funkcja Round:

Val= 43.837

Rval1=round(Val) #44

Rval2=round(Val,digits=2) #43.84

Funkcja MAX: Zwraca największą brakującą wartość z listy

X = maks. (2,6, NA, 8,0)

Funkcja MIN: Zwraca najmniejszą nie brakującą wartość z listy

Y = min (2,6,1,7,0, -2)

Funkcja Sum: zwraca sumę (całkowitą) wartości

Y = Sum(9,8,., 9)

Funkcja mean: Oblicza się ją, biorąc sumę wartości i dzieląc ją przez liczbę wartości w serii danych. Funkcja mean() służy do obliczenia tego w R.

# Utwórz wektor i znajdź jego średnią.

x <- c (7,3, NA, 4,18,2,54,8)

res_mean <- mean(x)

print (res_mean)

# Znajdź średnie spadające wartości NA.

resmean_na <- mean(x, na.rm = PRAWDA)

print (resmean_na)

Funkcja median: środkową wartością w serii danych jest mediana. Funkcja median() jest używana w R do obliczenia tej wartości.

# Utwórz wektor i znajdź medianę.

x <- c (12,7,3,4.2,18,2,54, -21,8, -5)

median.result <- mediana (x)

print (median.result)

Funkcje daty / godziny: Funkcje daty / godziny to zestaw funkcji, które zwracają części daty, wartości daty lub godziny lub konwertują wartości liczbowe na wartości R daty lub godziny. Te funkcje są przydatne do wyodrębniania daty i godziny z wartości daty i godziny lub przekształcania osobnych wartości miesiąca, dnia i roku w wartość daty R.

Funkcje Sys.Date, date: Funkcja zwraca dzisiejszą datę z zegara systemowego, nie wymagając żadnych argumentów.

Sys.Date() zwraca dzisiejszą datę.

date() zwraca aktualną datę i godzinę.

# print today's date

today <- Sys.Date()

format(today, format="%B %d %Y")

format(today, format="%m %d %Y")

format(today, format="%m %d %y")

Możesz zauważyć, że data systemowa jest prezentowana na różne sposoby, gdy zmieniamy format. Musimy znaleźć format, który lepiej pasuje do naszych wymagań i wybrać go. Konwertowanie znaków na datę: Możesz użyć funkcji as.Date () do konwersji danych znaków na daty. Format to As.Date (x, "format"), gdzie x to dane znakowe, a format daje odpowiedni format. Domyślny format to rrrr-mm-dd

Testdts <- as.Date(c("1982-07-12", "1975-03-01"))

# Użyj as.Date () do konwersji ciągów na daty

Testdts <- as.Date(c("1982-07-12", "1975-03-01"))

# liczba dni między 7/12/82 a 03/01/75

days <- Testdts [1] - Testdts [2]

ŁĄCZENIE DANYCH

Odczytywanie danych z dwóch lub więcej zestawów danych i przetwarzanie ich przez Append Rows, Append Columns, Merging

Dołączanie wierszy: Łączenie zestawów danych zasadniczo oznacza układanie jednego zestawu danych na drugim, to znaczy, biorąc pod uwagę dwa zestawy danych, wszystkie rekordy z drugiego zestawu danych zostaną dodane na końcu pierwszego zestawu danych podczas konkatenacji zestawów danych mają identyczną strukturę, ale inną zawartość. Przez strukturę rozumiemy, że tabele miałyby takie same nazwy kolumn, a kolumny miałyby ten sam typ (numeryczny lub znakowy). Jeśli kolumna istnieje w co najmniej jednym zestawie danych, ale nie w innym, kolumna ta jest uwzględniana we wszystkich rekordach wyjściowych, ale z brakującą wartością dla wszystkich rekordów w tabelach, które nie miały tej kolumny. Funkcja rbind umożliwia dołączenie jednego zestawu danych na dole drugiego, co jest znane jako dołączanie lub łączenie zestawów danych. Jest to przydatne, gdy chcesz połączyć dwa zestawy danych, które zawierają różne obserwacje dla tych samych zmiennych. Korzystając z funkcji rbind, musimy upewnić się, że każdy zestaw danych zawiera tę samą liczbę zmiennych i wszystkie nazwy zmiennych są zgodne. Konieczne może być usunięcie lub zmiana nazw niektórych zmiennych w tym procesie. Zmienne nie muszą być ułożone w tej samej kolejności w zestawach danych, ponieważ funkcja rbind automatycznie dopasowuje je według nazwy. Funkcja rbind nie identyfikuje duplikatów ani nie sortuje danych. Możesz to zrobić dzięki funkcjom unikalnym i zamówieniowym.

sale1 <- data.frame(Cust_Id = c(101,103,105),

Amount_Spent =c(1700,1200,3700),

Pur_dt = c(20-03-2015,20-03-2015,20-03-2015))

fix(sale1)

sale2 <- data.frame(Cust_Id = c(103,104,105,108),

Pur_dt = c(22-03-2015,22-03-2015,22-03-2015,22-03-2015),

Amount_Spent =c(1800,3400,2500,3200))

fix(sale2)

saleall <-rbind(sale1, sale2)

fix(saleall)

Zauważ, że nowy zestaw danych zawiera wszystkie oryginalne dane w oryginalnej kolejności, w tym dwie kopie danych dla Cust_Id 103 i 105. Możemy dołączyć dwa lub więcej zbiorów danych w ten sam sposób.

Dołączanie kolumn: Funkcja cbind wkleja jeden zestaw danych na bok innego. Jest to przydatne, jeśli dane z odpowiednich wierszy każdego zestawu danych należą do tej samej obserwacji. Funkcji cbind można używać tylko do łączenia zestawów danych o tej samej liczbie wierszy.

Scalanie zestawów danych przez wspólne zmienne: Funkcja scalania pozwala połączyć dwa zestawy danych poprzez dopasowanie obserwacji zgodnie z wartościami wspólnych zmiennych. Rozważ zestawy danych sale1 i loc1. Zestawy danych mają wspólną zmienną o nazwie Cust_Id, której można użyć do dopasowania odpowiednich obserwacji.

loc1 <- data.frame(Cust_Id = c(101,102,103,104,105),

Location =c("Hyderabad","Bangalore","Chennai","Hyderabad","Bangalore"))

Merdata <- merge(sale1,loc1)

fix(Merdata)

Funkcja merge identyfikuje zmienne o tej samej nazwie i używa ich do dopasowania obserwacji. W tym przykładzie oba zestawy danych zawierają zmienną o nazwie Cust_Id, więc R automatycznie używa tej zmiennej, aby dopasować obserwacje.

All_mer <- merge (sale1, loc1, all = T)

fix (All_mer)

Po połączeniu dwóch zestawów danych z funkcją merge R automatycznie wyklucza wszelkie niedopasowane obserwacje, które pojawiają się tylko w jednym z zestawów danych. Argumenty all, all.x i all.y pozwalają kontrolować, w jaki sposób R radzi sobie z niedopasowanymi obserwacjami. Aby zachować wszystkie niedopasowane obserwacje, ustaw argument all na T:

L_mer <- merge(sale1,loc1,all.x=T)

fix(L_mer)

R_mer <- merge(sale1,loc1,all.y=T)

fix(R_mer)

Aby połączyć dwie ramki danych (zestawy danych) w poziomie, użyj funkcji scalania. W większości przypadków łączysz dwie ramki danych za pomocą jednej lub więcej wspólnych zmiennych kluczowych (tj. sprzężenia wewnętrznego).

# scal dwie ramki danych według identyfikatora

total <- merge(data frameA,data frameB,by="ID")

Dodawanie wierszy: Aby połączyć dwie ramki danych (zestawy danych) pionowo, użyj funkcji rbind. Dwie ramki danych muszą mieć te same zmienne, ale nie muszą być w tej samej kolejności.

total <- rbind (data frame A, data frame B)

TRANSPOZYCJA DANYCH

Przekształcanie zestawu danych jest również znane jako Obracanie, Transpozycja lub Transformacja zestawu danych. Zwykle ma to zastosowanie do zestawów danych, w których wykonano powtarzane pomiary, funkcja zmiany kształtu służy do zmiany orientacji danych., Ale przed wykonaniem zmiany kształtu musimy zadać sobie następujące pytania:

• Co powinno pozostać takie samo

• Która zmienna powinna wzrosnąć

• Która zmienna powinna zmaleć

• Która zmienna powinna przejść na środek

# Przeniesienie danych

setwd("D:/R data")

Vitals <- read.csv("Vitals.csv")

fix(Vitals)

T_vitals<-reshape( Vitals, direction="wide", v.names="Result", timevar="VS_Test",

idvar="Pat_Id")

fix(T_vitals)

Ponieważ Pat_Id jest określony w idvar, pozostał na tej samej pozycji, wszystkie pozostałe zmienne zostały transponowane. Użyj argumentu v.names, aby określić zmienną, którą chcesz podzielić na różne kolumny. Użyj argumentu timevar, aby określić zmienną wskazującą, do której kolumny należy wartość. Użyj argumentu idvar, aby określić, która zmienna jest używana do grupowania rekordów.

KROK 5

Myślenie Statystyczne

WPROWADZENIE

Statystyka to nauka zajmująca się zbieraniem, klasyfikacją, analizą i interpretacją faktów liczbowych oraz wykorzystaniem teorii prawdopodobieństwa w celu uporządkowania agregatów danych. Przyjrzyjmy się niektórym problemom biznesowym, z którymi boryka się człowiek biznesu, gdzie potrzebuje statystycznych metod ich rozwiązywania.

• Gdzie powinniśmy otworzyć nasz nowy sklep detaliczny?

• Jak duże pomieszczenia powinniśmy wynająć?

• Ile osób powinienem obsłużyć w tym sklepie?

• Jaki jest odpowiedni poziom zapasów dla każdego produktu?

• Jak zwiększyć wartość klienta i ogólne przychody?

• Jak opracować nowe, udane produkty?

• Czy powinniśmy przyjmować zamówienia online, czy nie?

• Ile powinniśmy zainwestować w reklamę?

• Jak obniżyć koszty operacyjne?

TERMINOLOGIA STATYSTYCZNA

Przed rozwiązaniem wyżej wymienionych problemów przyjrzyjmy się terminom statystycznym, które pozwalają nam wygodnie radzić sobie z tymi scenariuszami.

Populacja: Populacja to kompletny zestaw elementów, które mają co najmniej jedną wspólną cechę.

Próbka: podzbiór populacji wybrany do analizy.

Parametr: miara obliczana dla całej populacji.

Statystyka: miara obliczana na próbce.

Statystyki opisowe: służą do opisywania lub podsumowywania danych w sposób znaczący i użyteczny. Możemy opisywać dane na wiele sposobów, takich jak miary tendencji centralnej, miary dyspersji, miary lokalizacji i kształtu rozkładu. Miary opisowe dają lepsze wyczucie danych i mogą przedstawiać ogólny obraz danych, statystyki te obejmują średnią, tryb, medianę, minimum, maksimum, wariancję, odchylenie standardowe, skośność, kurtozę itp.

Statystyki wnioskowania: metody wykorzystujące teorię prawdopodobieństwa do dedukcji właściwości populacji na podstawie analizy właściwości próbki danych z niej pobranej.

Statystyka predykcyjna: metody przewidywania przyszłych prawdopodobieństw na podstawie danych historycznych.

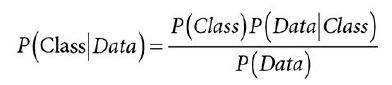

Statystyka preskryptywna: Metody pozwalają nam na określenie szeregu możliwych działań i prowadzą nas w kierunku optymalnego rozwiązania.